La scheda video giuntaci in redazione in questi giorni, appartiene al noto marchio Gainward, il quale rappresenta ormai da anni, garanzia di assoluta affidabilità e livello qualitativo.

La scheda video giuntaci in redazione in questi giorni, appartiene al noto marchio Gainward, il quale rappresenta ormai da anni, garanzia di assoluta affidabilità e livello qualitativo.Gainward Co..Ltd, fondata a Taipei nel 1984, è specializzata nella produzione di schede video. La sua gamma di prodotti copre dalla fascia entry-level a quella enthusiast. Proprio in quest'ultima fascia, si colloca l'imponente Bliss GeForce GTX 280.

NVIDIA con la sua ultima nata GTX 280, ha operato un raddoppio nel numero di stream processors integrati, passando dai precedenti 128 a 240 nella versione top di gamma GeForce GTX 280.

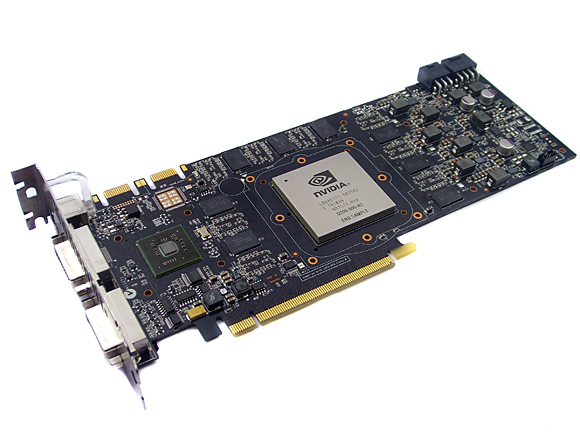

La scheda GTX 280 riprende in gran parte parte la forma delle precedenti soluzioni soluzioni NVIDIA, infatti occupa n. 2 Slot ed è racchiusa da un guscio plastico che ricopre completamente i componenti sia nella parte frontale che nella parte posteriore della scheda, in modo da meglio veicolare il flusso d'aria verso l'esterno.

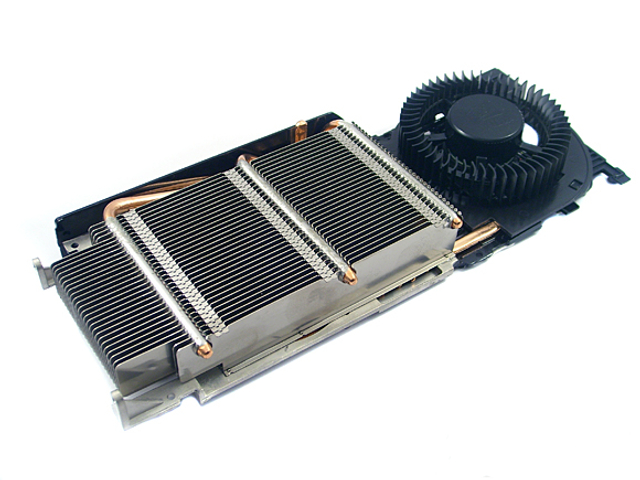

Nella parte posteriore della scheda è presente una ventola di raffreddamento, che aspira aria dall'interno del case soffiandola sui dispositivi di raffreddamento così che venga espulsa all'esterno del sistema.

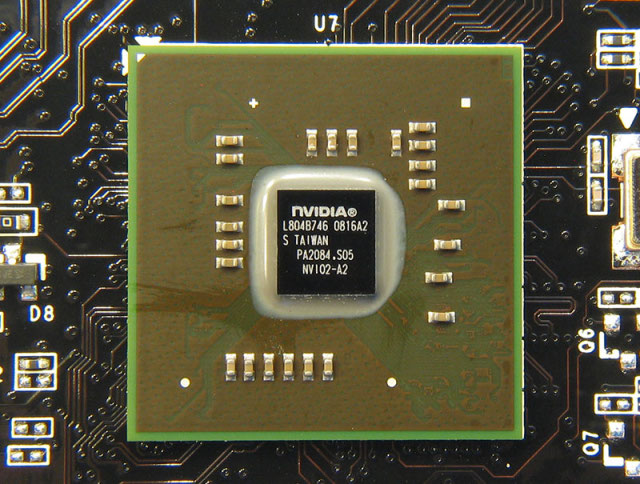

La scheda video è costituita da un unico chip grafico denominato GT200 .

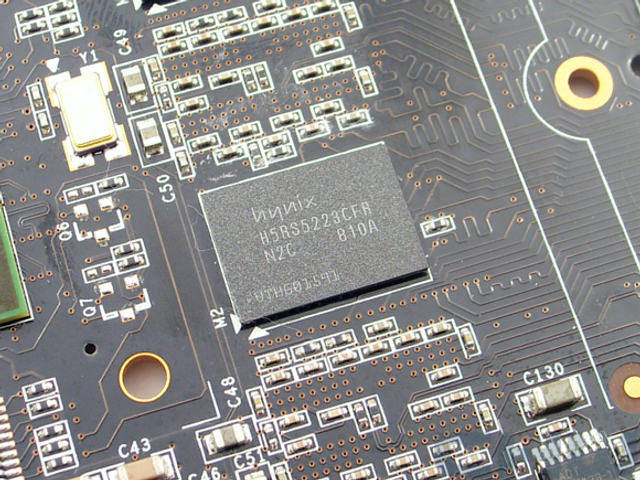

Il memory controller, passa da 256 bit delle precedenti versioni alle attuali 512bit della GTX 280. L'adozione di un bus memoria da 512bit di ampiezza ha richiesto l'utilizzo di 16 chip memoria per ogni scheda.

In quanto ogni chip è collegato al controller memoria attraverso un bus da 32bit di ampiezza.

Ogni chip memoria utilizzato da queste schede ha capacità complessiva di 512 Mbit, o 64 Mbytes: da questo ne risulta una dotazione di memoria pari a 1 Gbyte per la scheda oggetto della recensione.

I moduli di memoria adottano la tecnologia GDDR3, con frequenza di funzionamento pari a 2.214 MHz.

In questa recensione analizzeremo le caratteristiche principali, le prestazioni e le doti di overclock che la scheda sarà in grado di fornirci.

NVIDIA ha implementato nelle schede GeForce GTX 280 il proprio video processing engine chiamato “ Pure Video HD” di seconda generazione.

Il “ Pure Video HD è dotato di una migliore gestione dei flussi video ad alta definizione rispetto a quanto messo a disposizione dal VP1 implementato nelle precedenti GPU G80 di Nvidia.

Presentazione

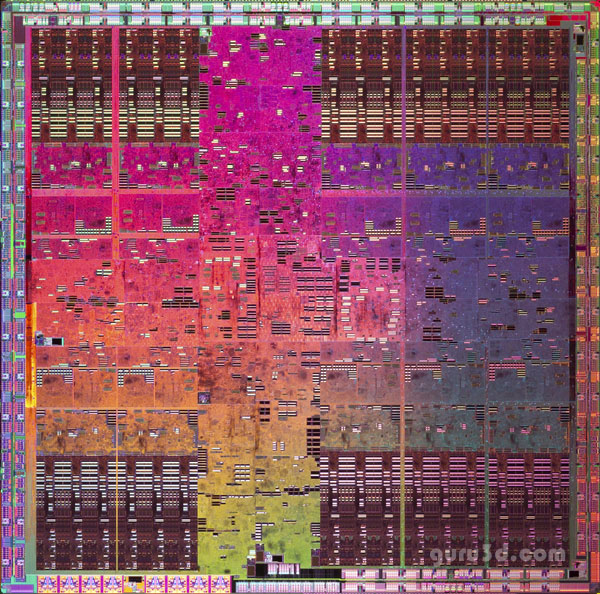

La Gainward Bliss GeForce GTX 280, è la decima generazione di architettura per la famiglia di prodotti NVIDIA. Attualmente rappresenta nella propria gamma di prodotti di fascia alta, la più veloce soluzione video a singola scheda. Questo chip è costruito con tecnologia produttiva a 65 nanometri nella fonderia taiwanese TSMC. Il chip GT200 in totale integrata ben 1,4 miliardi di transistor, per una superficie complessiva del die estremamente elevata, quantificata in circa 650 millimetri quadrati.

Purtroppo il processo produttivo a 65 nanometri non ha aiutato Nvidia a diminuire le dimensioni del die,creando non pochi problemi.

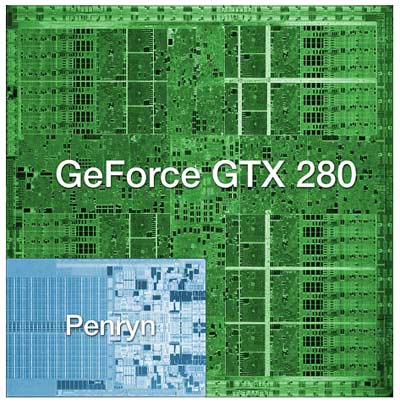

Impressionante la grandezza del die della GTX 280 messa a confronto con il processore Intel Penryn.

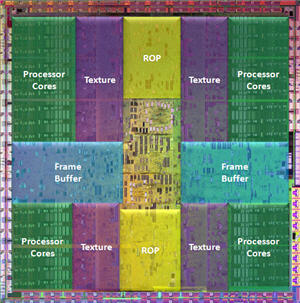

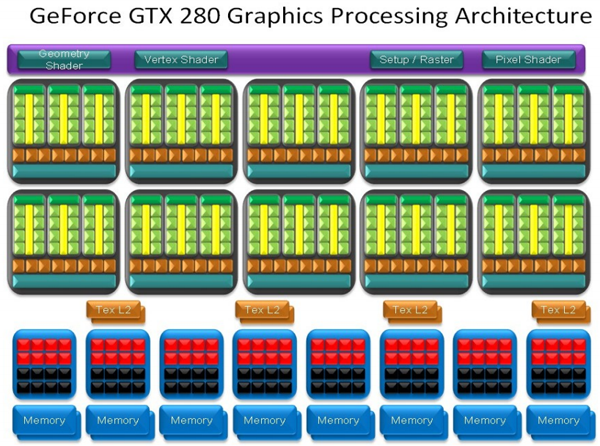

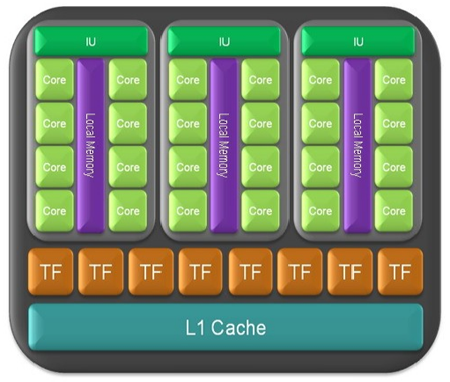

Con la GPU GT200 NVIDIA ha preso spunto dall'architettura utilizzata nelle soluzioni G80 e G92, introducendo significative innovazioni ma mantenendo invariato il design di base. Troviamo 240 stream processors (SP) nella scheda GeForce GTX 280, raggruppati a gruppi di 8 ciascuno in quelli che vengono indicati con il nome di “streaming multiprocessors (SM)”. Un gruppo di 3 “streaming multiprocessore” viene indicato con il nome di “thread processing cluster o TPC”: abbiamo quindi in totale 10 TPC e 30 SM per ogni scheda video GeForce GTX 280.

Negli schemi “sopra riportati” riguardanti l'architettura del GT200, possiamo immediatamente capire come NVIDIA abbia suddiviso internamente le varie unità di elaborazione. Nella parte superiore della GPU trova posto la logica che gestisce la suddivisione dei vari thread all'interno dei core, accanto alle unità per il setup e la rasterizzazione.

I 10 blocchi identici sono i TPC, all'interno dei quali sono chiaramente visibili le 3 SM, ciascuna dotata di 8 SP. Per ogni SM sono associate una unità di elaborazione full precision, indicata in colore verde nella parte superiore dell'SM, e due texture units distinguibili dal colore marrone. Ogni stream processor è capace di eseguire operazioni sia con interi che in virgola mobile, accedere alla memoria ed eseguire operazioni di logica. L'architettura è con pipeline multiple, in grado di eseguire una istruzione per ogni thread per ogni ciclo di clock.

Il file di registro locale interno ad ogni SM è stato raddoppiato rispetto a quello implementato nelle precedenti GPU G80 e G92; questo permette alla GPU GT200 di elaborare un numero maggiore di shader, o shader di più elevata complessità, senza necessità di eseguire swap verso la memoria con un conseguente impatto negativo sulle prestazioni.

Diverse ottimizzazioni, sono state apportate da parte di Nvidia all’interno alle special function unit interne agli SM, così da ottenere maggiore efficienza nell'utilizzo delle istruzioni in virgola mobile MUL. In particolare ogni stream processor può elaborare quasi a piena velocità due operazioni di tipo MAD (Multiply-Add) e una di tipo MUL, utilizzando l'unità MAD integrata nello stream processor per eseguire un MUL e un ADD per ogni ciclo di clock, accanto all'unità SFU che esegue una seconda operazione MUL. Pertanto risulta che ogni stream processor ha una potenza di elaborazione massima pari a 933 Gigaflops in elaborazioni in virgola mobile single precision.

Abbiamo detto che all'interno di ogni SM sia presente una unità di calcolo double precision. Nvidia ha infatti implementato nelle GPU GT200 anche questa funzionalità, particolarmente importante soprattutto quando la GPU viene utilizzata per elaborazioni di GPU Computing, ovvero per calcoli paralleli tipicamente delegati alla cpu, grazie alla nuova tecnologia “CUDA”, che vedremo ed analizzeremo in seguito.

Considerando che ogni 8 stream processor è presente una unità di calcolo double precision, la potenza elaborativa massima effettivamente ottenibile in double precision con una GPU GT200 è circa pari a 90 Gigaflops.

Nel GT200 troviamo un bilanciamento tra la capacità di indirizzare le textures e di filtrarle. Le unità implementate permettono infatti di indirizzare 80 textures in totale per ogni ciclo di clock, oppure di filtrare 80 pixel bilinerar o 40 pixel filtrati 2:1 anisotropic. Architettura simile anche per le ROPs, che sono state incrementate fino a 32. Troviamo il supporto a AA supersampled, multisampled, transparency adaptive e coverage sampling, oltre al blending di frame buffer di render target surfaces in virgola mobile, sia FP16 che FP32. Le ROPs possono operare con un output massimo di 32 pixel per clock, ottenuto con l'elaborazione di 4 pixel per ciclo di clock per ciascuna delle 8 partizioni; nello schema di funzionamento della GPU GT200 si notano le 8 partizioni nella parte inferiore, ciascuna collegata direttamente a due coppie di chip memoria con un bus a 64bit. 32 ROPs vogliono dire 32 pixel per clock in output e 32 pixel per clock in blend: le nuove unità, infatti, possono eseguire blend a velocità doppia .

Uno dei principali limiti delle precedenti soluzioni Nvidia erano da ricercarsi nelle prestazioni con geometry shader:. NVIDIA è intervenuta in GT200 per migliorare sensibilmente questo elemento architetturale, portando ad un incremento di 6 volte dei buffer di output interni alla GPU. Infatti sono presenti varie ottimizzazioni minori all'interno della GPU; il protocollo di comunicazione è stato migliorato così da incrementare l'efficienza nelle trasmissioni tra il driver e il front end.

La Gainward Bliss GeForce GTX 280 ha frequenza di clock è pari a 602 MHz. Nel GTX 280 troviamo l'utilizzo di 16 moduli memoria, ciascuno con un bus da 32bit di ampiezza per un totale di 512bit; la risultante è una bandwidth massima pari a ben 141,7 Gbytes al secondo, grazie all'utilizzo di moduli memoria GDDR3 da 2.214 MHz di clock.

Si noti, come il programma GPU-Z riconosca in maniera esatta, tutte le caratteristiche della GPU.

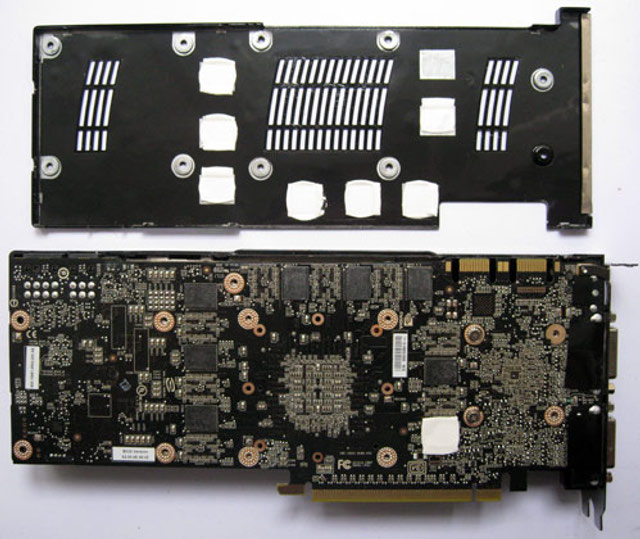

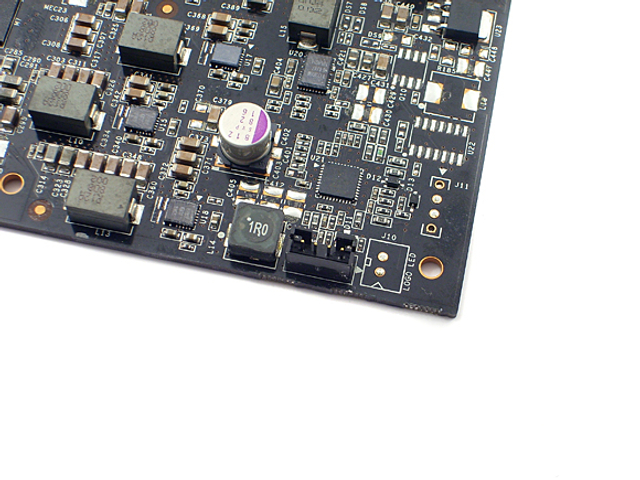

I chip memoria sono disposti su entrambi i lati del PCB della scheda video. Come è di consuetudine, il PCB delle ultime schede video Nvidia sono di colore nero.

La soluzione GeForce GTX 280 integra 1 Gbyte di memoria video di tipo DDR3. Questo valore dovrebbero permettere di sfruttare al meglio risoluzioni video molto elevate “oltre i 1920x1200” , in abbinamento ai giochi particolarmente esigenti in termini di dotazione massima di memoria, evitando che i frames al secondo vengano fortemente penalizzati.

Specifiche Tecniche

Riportiamo di seguito le caratteristiche riassuntive della Gainward GeForce GTX 280:

|

Gainward GeForce GTX 280 |

|

|

Modello: |

Gainward GeForce; |

|

Versione: |

Nvidia GTX 280; |

|

GPU: |

GT200; |

|

Processo produttivo (nm): |

65 nm; |

|

Stream processor: |

240; |

|

Clock stream processor (GHz): |

1,296; |

|

Clock chip (MHz): |

602; |

|

Numero di Rops: |

32; |

|

Texture filtering unit: |

80; |

|

Bus di memoria (in bit): |

512 bit; |

|

Quantità e tipo di memoria (MB): |

GDDR3 – 1024Mb; |

|

Clock memoria (GHz): |

2.214 Ghz; |

|

Banda memoria (GB/s): |

141,7 |

|

Video processing engine: |

VP2 |

|

Prezzo indicativo di vendita: |

375,00 € |

Sentiamo la necessità di abbinare alla scheda video un’ alimentatore di buona fattura da almeno 550W dotato di connettore di alimentazione PCI-E da 6 e 8 pin e con almeno 40A sulla linea dei 12v, al fine di non aver sgradite sorprese.

Tutte le GeForce GTX 280 proposte sul mercato dai partner AIB di Nvidia sono basate sul reference design sviluppato dal produttore californiano, fatta eccezione solo per alcune soluzioni che differiscono tra di loro per le diverse frequenze di funzionamento del core, delle ram o per il diverso “impianto di dissipazione” della GPU usato.

A questa regola, non si discosta la proposta della Gainward analizzata in questa recensione, basata su un design sviluppato dal produttore californiano.

La confezione si presenta con una scatola di cartone ed è di dimensioni molto generose, infatti misura ben 40,0x27,5x7,0 cm.

Nella confezione sono riportate le caratteristiche principali della VGA con i loghi ben visibili e riconoscibili.

Aperta la scatola, troviamo la scheda alloggiata all'interno di una busta antistatica, il tutto è alloggiato in un apposito vano di cartone bianco.

La scheda video Gainward GeForce GTX 280 ricalca il reference design di nVidia, l'unica personalizzazione visibile, è l'applicazione degli adesivi con i colori del marchio, è lunga 27, alta 12 e larga 4,5 Cm.

La scheda pesa ben 1.6 Kg. Il PCB è sigillati all'interno di un robusto case metallico, questa soluzione garantisce una elevata sicurezza contro i danneggiamenti e un buon comfort acustico. L'aspetto della scheda è imponente, nei fatti un parallelepipedo in grado di occupare due slot in spessore.

Si nota fin da subito la presenza di due connettori DVI, a fianco dei quali si può notare il connettore HDMI. Sulla staffa si nota una piccola porzione con alcune feritoie, per la fuoriuscita del flusso di aria calda proveniente dal dissipatore di calore.

Durante l'installazione bisogna prestare attenzione a dove si collega il monitor. Ricordiamo che solo il connettore HDMI e il DVI adiacente, sono abilitati al boot del sistema.

Sono disponibili due connettori DVI Dual LINK con supporto HDPC e HDMI per veicolare audio multicanale attraverso una connessione dati interna. Un piccolo led indica la corretta alimentazione della scheda, nel caso che, uno o entrambi i connettori di alimentazione non fossero correttamente collegati il led cambierà colore indicando il problema.

Le connessioni presenti sulle schede GeForce GTX 200 sono due dual link DVI, capaci di gestire anche segnale HDMI attraverso un adattatore apposito, oltre al tradizionale connettore per output TV anche di tipo video component. I due link DVI sono compatibili con le specifiche HDCP, permettendo quindi di inviare segnali video ad alta definizione protetti come quelli dei supporti Blu-ray anche su display che utilizzino risoluzione superiore a quella di 1920x1080 pixel, sfruttando completamente tutta la risoluzione video a disposizione.

La connessione HDMI video può essere affiancata anche dal segnale audio, grazie ad un connettore SPDIF integrato sulla scheda video posizionato accanto ai due connettori di alimentazione.

NVIDIA abbia implementato con le GPU GT200 la gestione dell'output video a 10bit per componente; con le GPU precedenti le elaborazioni venivano sempre eseguite internamente con precisione di 10bit per componente, ma limitando l'output video a 8bit per via delle tecnologie display disponibili sul mercato. Per poter sfruttare appieno questa funzionalità sarà ovviamente necessario utilizzare un display con supporto a segnali 10bit per componente.

Il retro della scheda è privo di personalizzazioni, questo ci da la possibilità di ammirare il metallo ben lucido. Questa soluzione esteticamente molto bella e sarà apprezzata da chi installa la scheda su un banchetto o su un case finestrato.

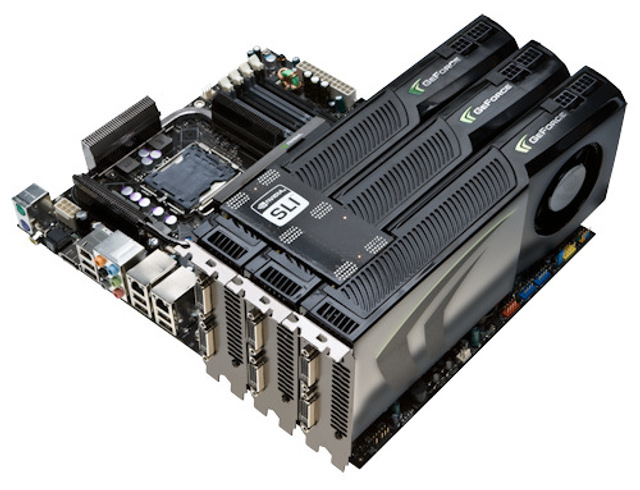

Elemento di continuità tra le precedenti schede video NVIDIA e la soluzione GeForce GTX 280 è la tecnologia SLI.

Sulla scheda sono presenti due distinti connettori, con i quali poter configurare sistemi SLI tradizionali o Triple SLI.

Manca chiaramente il supporto alla tecnologia Quad SLI, in quanto quest'ultima è ottenuta affiancando in SLI due schede video dotate ciascuna di due GPU, per un totale quindi di quattro GPU contemporaneamente presenti nel sistema, ma in compenso si può fare il Triple SLI. Vedremo in seguito in che modo.

I connettori di alimentazione sono originariamente coperti da un adesivo al fine di richiamare l'attenzione dell'utente al collegamento dei cavi aggiuntivi. Per il corretto funzionamento della scheda è necessario collegare un cavo PCI-E 6 pin e un cavo PCI-E 8 pin. Nella stessa area è presente una connessione 2 pin per il cavo SDPIF, necessario per veicolare l'audio al connettore HDMI integrato.

Foto Gainward GeForce GTX 280 – 025

La dotazione fornita in bundle con la scheda video comprende:

- CD-Rom con driver per l'installazione della scheda video;

- Manuale della scheda;

- N.2 adattatori da DVI a VGA;

- 1 Cavo Tv out , HDTV support;

- Un tappetino per il mouse;

- Un convertitore da DVI a HDMI;

- Gioco completo Tomb Raider Anniversary.

Foto Gainward GeForce GTX 280 – 026

Caratteristiche tecniche

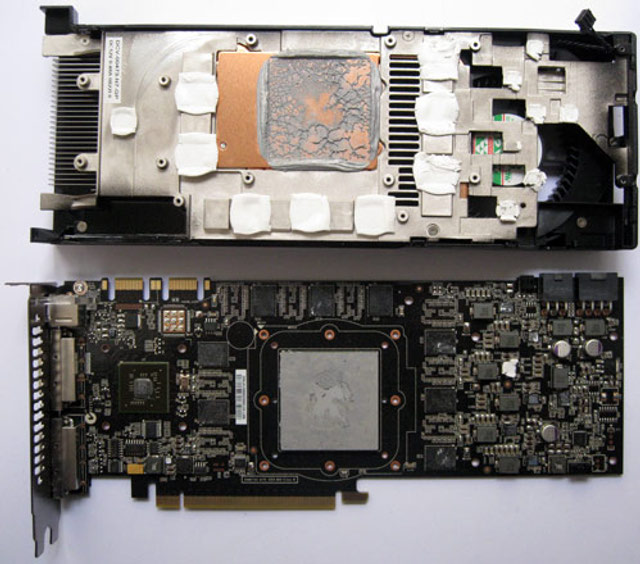

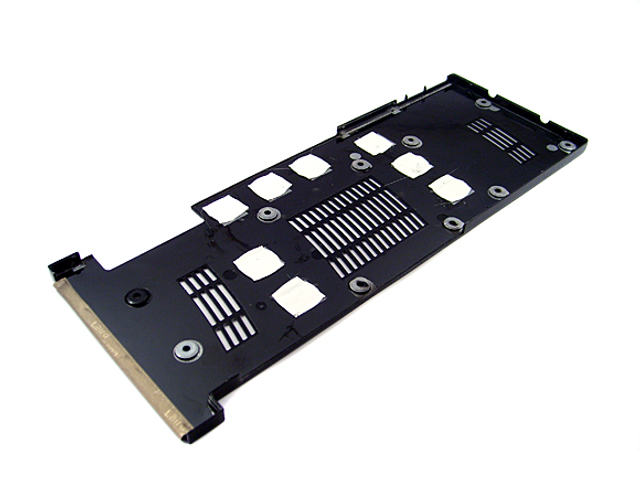

La scheda video così come viene commercializzata nella versione di riferimento NVIDIA, è ricoperta interamente da una solida copertura metallica.

Non vi sono componenti attivi o passivi a vista, il case offre un'ottima resistenza meccanica e una notevole resistenza strutturale, ma non lascia praticamente intuire il lavoro di ottimizzazione della struttura interna.

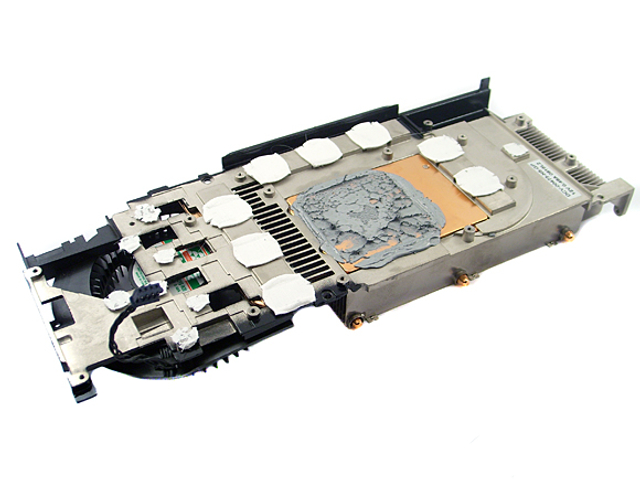

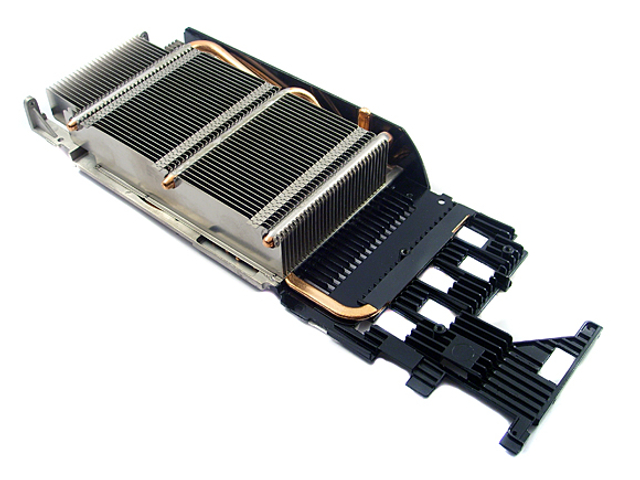

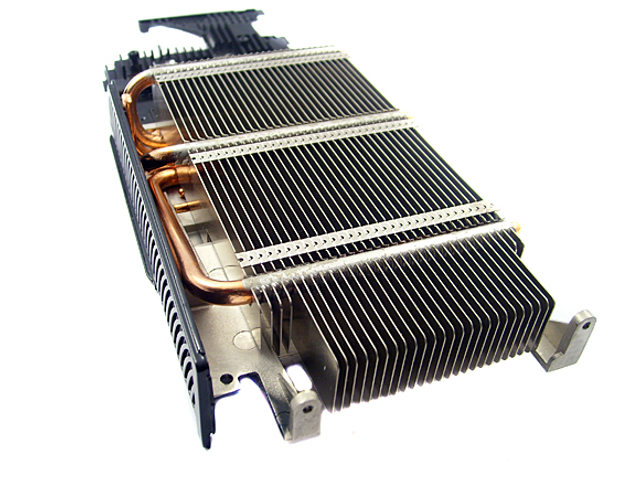

Non è stato per niente difficile rimuovere il dissipatore che ricopre interamente la GPU, è bastato svitare con attenzione le viti di fissaggio del dissipatore con il PCB della GPU.

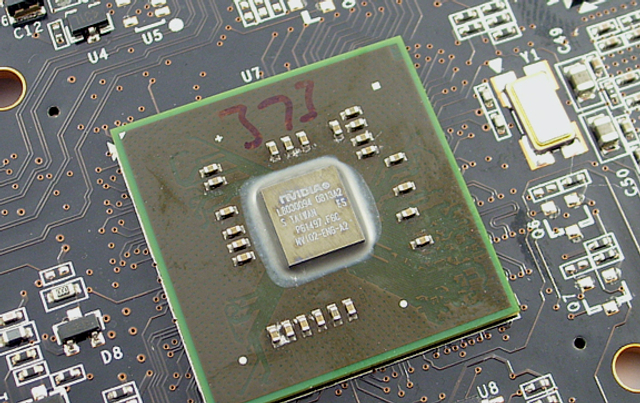

Appena smontato il dissipatore, si nota il chip dedicato al Video processing engine.In questo caso si tratta del NVIO2-ITA-A2, evoluzione del precedente.

Il sistema di raffreddamento è studiato appositamente su misura per questo modello, è trova spazio all'interno del "sandwich" costituito dai due PCB. La ventola a turbina crea un flusso che, dopo aver attraversato tutta la lunghezza della scheda, si dirige verso le feritoie nella staffa.

I moduli memoria sono 16, ciascuno con un bus da 32bit di ampiezza per un totale di 512bit;di tipo GDDR3 da 2.214 MHz di clock.

I chip delle ram sono i Hynix siglati H5RS5223CFR-N2C. Si tratta di chip da 0.83ns, in grado quindi di lavorare fino a 2400MHz di frequenza di clock massima, sinonimo che Gainward indirizza la scheda appositamente agli amanti dell’Overclock.

La scheda video supporta una risoluzione massima di 2560x1600 garantendo una uscita video a 480p, 720p, 1080i.

La GeForce GTX 280 introduce o migliora le esistenti funzioni tecnologica introdotte in passato. Una nuova tecnologia appositamente sviluppata con l’avvento della GeForce GTX 280 è la tecnologia CUDA. Cuda si va ad affiancare ad altre tecnologie già presenti nei prodotti Nvidia.:

- Hybrid SLI;

- Pure Video HD;

- Triple SLI;

- PCI Express 2.0;

- Tecnologia CUDA Parallel Processing ;

- nVidia PhysX;

- FSAA;

Andiamo di seguito ad analizzarle in dettaglio:

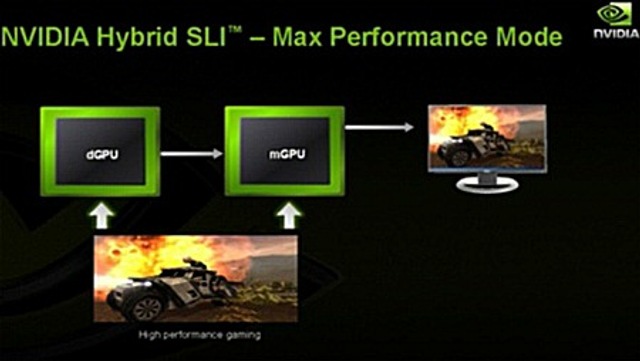

Hybrid SLI:

Attraverso Hybrid SLI, NVIDIA permette all´utente di utilizzare in maniera efficiente la grafica integrata nel chipset e l´eventuale scheda grafica discreta utilizzata nel sistema. Grazie alla combinazione dei due chip grafici, NVIDIA afferma sia possibile ottenere prestazioni elevate quando necessario e consumi ridotti quando invece non sono richiesti grossi sforzi computazionali.

L´arrivo della tecnologia Hybrid SLI segna anche una svolta nella politica della casa californiana relativamente ai chipset con grafica integrata: se finora questi erano relegati solo al segmento entry level del mercato, oggi NVIDIA li propone in tutte le salse e per tutte le tasche. Dunque tutti i chipset di nuova generazione presenteranno un core grafico integrato.

Della tecnologia Hybrid SLI fanno parte due componenti fondamentali, ovvero HybridPower e GeForce Boost. La prima, come si capisce anche dal nome, permette di gestire al meglio la componente di risparmio energetico, grazie alla possibilità di spegnere completamente la scheda grafica discreta quando le sue funzionalità non sono richieste, lasciando invece accesa la GPU integrata.

Per usare la tecnologia Hybrid power, il sistema necessita di un chipset Nvidia IGP e di una scheda grafica esterna NVIDIA.

Questa tecnologia attualmente funziona solo con il sistema operativo Microsoft Windows Vista.

Il monitor deve essere collegato al connettore grafico presente sulla scheda madre e quando è richiesta la potenza della scheda grafica discreta, il contenuto del frame buffer di questa è copiato su quello del processore grafico integrato.

NVIDIA afferma che non ci sono problemi di banda dati grazie all´utilizzo dello standard PCI Express 2.0 mentre quello della latenza è, sempre secondo dichiarazioni del produttore, un "non-problema".

Il secondo aspetto, ovvero il GeForce Boost, permette invece di combinare la potenza del chip integrato (per la cronaca NVIDIA lo chiama mGPU) e della GPU discreta (dGPU) per migliorare le prestazioni 3D.

A differenza della tecnologia CrossFire Ibrido di ATI, la scheda video discreta può essere spenta completamente, annullandone i consumi, in futuro questa modalità sarà attivabile anche con configurazioni SLI, riducendo drasticamente le richieste energetiche di questi sistemi, quando non è necessaria la “forza bruta”.

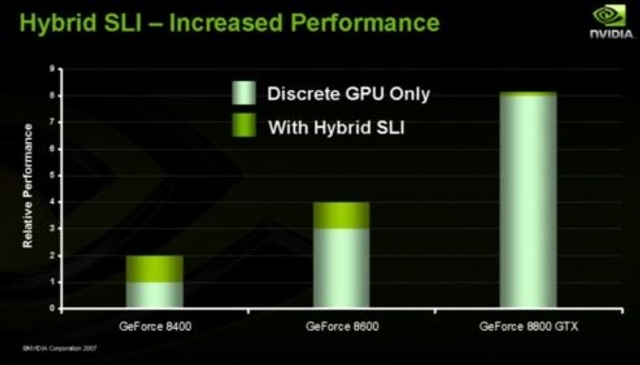

NVDIA afferma che questa tecnologia è molto interessante per i sistemi low-end o mid-range nei quali si registrano i migliori incrementi prestazionali:

Attualmente la tecnologia Hybrid SLI è disponibile sia su piattaforma AMD che Intel.

Pure Video HD:

Con la serie GT200, NVIDIA migliora la precedente tecnologia Pure Video introdotta con la serie 9000, per migliorare ulteriormente la qualità della riproduzione dei film in formato standard e alta definizione.

Le schede NVIDIA sono in grado di accelerare in Hardware tutti i 3 principali codec presenti sul mercato, MPEG 2 (DVD Video), VC-1 e H.624 (HD DVD e Blue Ray).

Tutte le funzionalità Pure Video HD sono configurabili dal pannello di controllo NVIDIA e non richiedono codec aggiuntivi. E’ necessario usare solo un player compatibile, come ad esempio i prodotti di CyberLink, InterVideo e ArcSoft.

La tecnologia Pure Video HD, non solo permette di sgravare la CPU di sistema da tutti i calcoli necessari per la decodifica dei flussi video, ma permette inoltre di migliorare i colori, attivare funzionalità di salatura “senza perdita” di qualità, de interlacciamento e riduzione del rumore.

Con gli ultimi driver è inoltre possibile riprodurre due video in HD contemporaneamente senza disabilitare le funzionalità Areo di Windows Vista.

NVIDIA ha presentato un nuovo software di codifica video basato sulla tecnologia CUDA, dal nome BadaBOOM Media Converter. Il programma è sviluppato da una azienda americana specializzata in tecniche di video processing è permette di convertire un video in definizione standard (es. DVD) in un file codificato in H.264. E’ anche possibile codificare i video in HD a risoluzioni minori senza perdere molta qualità.

Triple SLI:

Il Triple SLI, che permette l'utilizzo di tre schede video in parallelo al fine di aumentare le prestazioni in campo videogiochi e consente risoluzioni e impostazioni qualitative elevate.

Il supporto alla tecnologia Triple SLI richiede necessariamente la presenza di due connettori SLI sul PCB di ogni scheda video. NVIDIA, all'atto pratico, offre da oggi driver per l'attivazione del Triple SLI su sue schede madri proprietarie.

La configurazione Triple SLI prevede l'adozione di un particolare connettore, che verrà consegnato in bundle con le schede madri Nvidia in grado di gestire il Triple SLI.

La configurazione è in ogni caso realizzabile attraverso tre connettori SLI tradizionali, adottando il seguente schema:

Ricordiamo che il Triple SLI sarà sopportato solo ed esclusivamente dalle schede madri Nvidia, essendo la stessa Nvidia proprietaria di questa tecnologia, come succedeva con la tecnologia SLI classica.

Il Triple SLI attualmente sarà una prerogativa esclusiva dei sistemi dotati di Windows Vista, infatti solo l'ultimo sistema di casa Microsoft implementa il framework necessario per il rendering di 3 frame, tecnologia necessaria per l'utilizzo di 3 GPU in modo efficiente.

I nuovi driver NVIDIA permetteranno la scalabilità di tutti i componenti grafici (geometry, texture, shader processing) al fine di massimizzare le prestazioni.

Ricordiamo che per utilizzare un sistema Triple SLI di NVIDIA con tre schede video GeForce GTX 280 si necessita di una potenza non indifferente di alimentazione. A tal proposito raccomanda un alimentatore di marca da almeno 1000w.

PCI Express 2.0:

Il nuovo supporto al PCI Express 2.0 si mantiene compatibile con la versione 1.0, porta con sé diverse novità, la più importante delle quali è data dal raddoppio della frequenza operativa, e di conseguenza della banda passante per singola via: dai 2,5 gigatranfers al secondo (GT/s) dell'attuale bus si è passati a 5 GT/s. La velocità di un link in modalità x16 è ora all'incirca di 16 Gbyte/s.

La maggiore velocità del bus sarà importante sia per supportare l'evoluzione delle altre interfacce di comunicazione dei PC, come SATA e SAS, sia per sostenere il traffico generato dai controller di rete multi porta e dalla nuova generazione di schede grafiche DirectX 10, specie se in configurazione dual-Gpu.

Il PCI-express 2.0 è in grado di erogare fino a 300 watt di potenza, più che sufficiente a sostenere il fabbisogno energetico delle schede grafiche più performanti.

PCI-express 2.0 introduce inoltre diverse nuove funzionalità a livello di protocollo che, secondo quando spiegato da PCI-SIG, "permettono agli sviluppatori di progettare dispositivi più intelligenti e capaci di ottimizzare le performance della piattaforma e ottimizzare i consumi energetici.

Il PCI Express 2.0 offrirà slot x1, x4, 8x e 16x come il suo predecessore, ma la frequenza sarà di 250 MHz contro i 100 MHz attuali.

PCI-ex 2.0 permette poi una più avanzata gestione delle periferiche, degli slot, delle interconnessioni, dei trasferimenti peer-to-peer, dei timeout, dei dispositivi multifunzione, degli accessi e del routing dei pacchetti. Si segnala infine la funzione Input-Output Virtualization (IOV), progettata per semplificare la condivisione delle periferiche PCI-ex fra più macchine virtuali.

Ricordiamo che le schede madri Intel x38 e x48 e NVIDIA nForce 790i

supportano il PCI Express 2.0 a 16x.

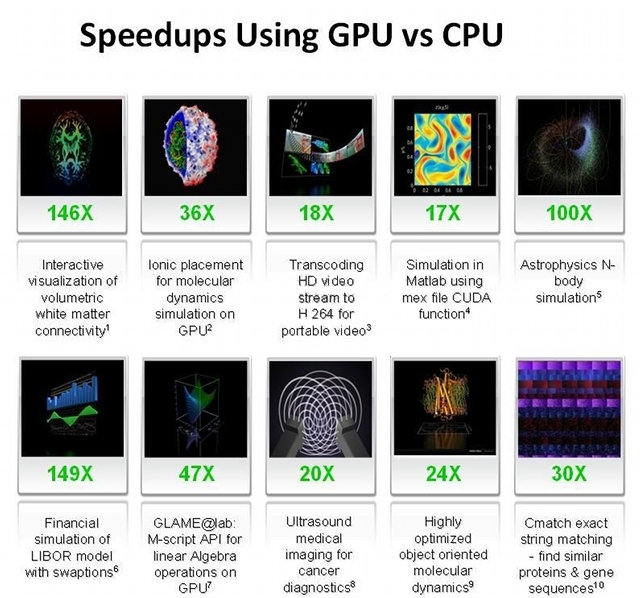

Tecnologia CUDA Parallel Processing:

La tecnologia NVIDIA CUDA è il solo ambiente in linguaggio “C” che permette a programmatori e sviluppatori di programmare applicazioni software in grado di risolvere i problemi di calcolo più impegnativi riducendo nettamente il tempo necessario grazie alla potenza di elaborazione in parallelo multi-core delle GPU.

I prodotti compatibili con NVIDIA CUDA possono aiutare ad accelerare le operazioni più impegnative, per esempio, codifica audio e video, prospezione petrolchimica, progettazione di prodotti, imaging medico e ricerca scientifica, solo per citare le più eclatanti. Molti programmi CUDA richiedono almeno 256 MB di memoria residenti sulla GPU.

Nei prossimi mesi saranno rilasciati applicativi commerciali che supporteranno questa tecnologia, primi fra tutti Adobe Photoshop CS4 e Badaboom Media Converter.

Ricordiamo che già attualmente la tecnologia CUDA riesce ad accelerare programmi come GPUGRID. Il team del progetto PS3GRID ha annunciato il supporto per le GPU nVidia con BOINC. Nasce così GPUGRID, il primo progetto BOINC per GPU. GPUGRID si propone di creare una potente infrastruttura per le simulazioni biomolecolari sfruttando oltre alla potenza delle PS3, anche la potenza delle GPU.

Il settore del HIGH Performance Computing, è continua espansione e NVIDIA vuole entrare in questo mercato con una soluzione matura e facile da implementare; i maggiori competitor sono i cluster a basso costo x86, ma il rapporto costi prestazioni è nettamente a favore della soluzione NVIDIA. Per quanto riguarda la fascia più alta del mercato, IBM, SUN e Cray sono sempre ai primi posti tra le scelte delle maggiori aziende.

Riassumendo, con la nuova tecnologia CUDA abbiamo:

- Linguaggio C standard per lo sviluppo di applicazioni in parallelo sulle GPU

- Librerie numeriche standard per FFT (Fast Fourier Transform) e BLAS (Basic Linear Algebra Subroutines)

- Driver CUDA dedicato per l’elaborazione con un percorso di trasferimento dati velocizzato tra GPU e CPU

- Il driver CUDA è interoperabile con i driver grafici OpenGL e DirectX

- Supporto per i sistemi operativi Linux a 32/64 bit e Windows XP a 32/64 bit

Attualmente sono molto pochi i programmi che sfruttano a pieno le potenzialità di CUDA. Siamo sicuri, che con il tempo il progetto portato avanti da Nvidia riserverà diverse sorprese interessanti.

nVidia PhysX:

Dopo la recente acquisizione di Ageia da parte di NVIDIA, la casa californiana, ha deciso di integrare attraverso la tecnologia CUDA, tutte le funzionalità delle PPU (unità di elaborazione della fisica) all'interno della scheda video GTX 200 . Attualmente sono disponibili i driver per il pieno supporto di queste nuove librerie.

La tecnologia PhysX offre un incremento nella potenza di elaborazione della fisica virtuale e porta i giochi ad ottenere un maggior realismo grazie alla possibilità di creare ambienti ricchi e coinvolgenti, dotato di funzionalità quali:

- Esplosioni che provocano la comparsa di nubi di polvere e detriti;

- Personaggi con geometrie complesse e dotate di giunture per rendere più verosimili; movimenti e interazioni;

- Nuove e spettacolari armi dotate di effetti speciali davvero straordinari;

- Tessuti che si tendono e si strappano in modo naturale;

- Fumo e nebbia densi che creano volute attorno agli oggetti in movimento.

Attualmente sono veramente molto pochi i giochi che sfruttano la PhysX di Nvidia. Il nuovo benchmark di Futuremark , ovvero il “3DMark Vantage “, sfrutta le librerie della PhysX., apportando benefici tangibili. Sicuramente in un futuro prossimo, diverse case produttrici di giochi decideranno di implementare queste nuove funzionalità.

FSAA:

Il FSAA che significa ” Full Scene AntiAliasing ”.Rappresenta un compromesso tra qualità e “peso” dei calcoli. Il FSAA non agisce solo sui bordi dei modelli renderizzati, ma sull’intera immagine (da cui Full Scene).

Per ottenere un buon FSAA è necessario renderizzare (e mantenere in memoria) un certo numero di versioni della stessa immagine. Maggiore sarà il numero di tali versioni e migliore sarà la qualità del FSAA.

Le versioni dell'immagine vengono generati effettuando delle minime variazioni (Jitter) della visuale corrente. Il valore minimo per il FSAA è costituito da due samples (AA 2x), mentre già con quattro varianti si ottiene un ottimo risultato (AA 4x). Per generare il FSAA è necessario dalle due alle quattro volte il tempo necessario per un rendering senza AntiAliasing. Il FSAA consente risultati comparabili al TEAA come resa visuale, ma richiede una gran quantità di memoria per stoccare le diverse versioni dell'immagine.

Tale tecnica è quindi attuabile su sistemi dotati di molta memoria video.

In sintesi, i vantaggi del FSAAsono nel basso sfruttamento della CPU e nella buona qualità visiva.

Il principale aspetto negativo consiste nella necessità di grandi quantitativi di memoria video.

La vga è compatibile con le librerie Microsoft DirectX 10.0 e Shader Model 4.0.

Ricordiamo che le DirectX 10 sono usufruibili solo con il nuovo sistema operativo Microsoft “Windows Vista”.

Di recente, Microsoft ha rilasciato per il suo nuovo sistema “Windows Vista” il Service pack 1.

Tre le tente novità introdotte dal Service pack 1, troviamo l’aggiornamento delle librerie Microsoft DirectX 10 in 10.1.

Nvidia con la GeForce GTX 280 non offre alcun supporto alle nuove librerie Microsoft DirectX 10.1

Le Direct3D 10.1 sono pienamente compatibili con la versione 10.

Le Direct3D 10.1, derivano direttamente dalle Direct3D 10, e ne aggiungono alcune caratteristiche.

Il passaggio alle Direct3D 10 ha portato molte novità, ma come spesso accade in queste situazioni, le nuove API erano affette da alcuni errori. La versione 10.1 è una sorta di aggiornamento che corregge i problemi ed elimina alcune restrizioni.

Tutti i miglioramenti possono essere riassunti in tre categorie:

- Rigorose specifiche per limitare le discrepanze tra implementazioni multiple.

- Una manciata di nuove caratteristiche

- Maggiore qualità e precisione di rendering e antialiasing

Ora è obbligatorio supportare il filtraggio texture FP32, mentre nella versione 10 era solo opzionale.

E’ obbligatorio anche il blending integer a 16 bit.

Le Direct3D 10 introducono il “Cube Map Arrays”. Con le Direct3D 10, Microsoft ha introdotto i Texture Arrays, tabelle di texture che possono essere indicizzate direttamente negli shader. I Texture Arrays ricordano le Texture 3D, in circolazione da molto tempo, ma praticamente il loro comportamento è molto differente. Quando si accede a un elemento delle texture 3D, viene applicato ai vari layer un filtraggio, comportamento normale poiché una texture 3D è caratterizzata da un volume. Diversamente, le texture presenti nella tabella non hanno nessun nesso tra loro. Conseguentemente, non c'è alcun filtraggio tra gli elementi limitrofi. Inoltre, quando si usa il mipmapping, una texture 3D è divisa in 2 secondo le 3 dimensioni, mentre con le texture arrays ciò non avviene: se la composizione delle varie texture vede una diminuzione delle loro dimensioni, la dimensione della tabella rimane inalterata.

Le Direct3D 10.1 generalizzano queste Texture Arrays aggiungendo il supporto alle Cube Maps, mentre fino ad ora, erano supportate solo le tabelle di texture 1D e 2D.

Ci chiediamo come mai Nvidia non abbia ancora deciso di supportare le nuove librerie Microsoft DirectX 10.1, questa mossa di fatto rallenta lo sviluppo dei giochi con queste nuove funzionalità che porterebbero senza dubbio vantaggi al consumatore finale.

Per quanto riguarda lo Shader Core, Nvidia ancora una volta, rimane fedele al vecchio Shader Model 4.0,pur sapendo che potrebbe adottare lo Shader Model 4.1

Lo Shader Model 4.1 apporta alcune novità come il Gather-4.

Per aggiornare la memoria più velocemente, questa istruzione permette di recuperare 4 elementi non filtrati da una single-channel texture con un solo texture fetch, che quindi permette un'implementazione più efficiente e personalizzati dei filtri negli shader.

Un'altra istruzione presente nello Shader Model 4.1 permette di recuperare il livello di dettaglio (mipmal level) durante un texture sampling. Microsoft ha aggiornato anche alcuni limiti, specialmente il numero di input vertex shader, passando da 16 vettori a 128 bit (4 floating point precision) a 32.

Per quanto riguarda il blending, abbiamo già menzionato il nuovo formato supportato, Int 16, ma non è l'unica novità; le Direct3D 10.1 ora permettono l'utilizzo di modalità di blending indipendenti durante rendering simultanei in più di un buffer (MRT: Multiple Render Targets).

Con le Direct3D 10.1, Microsoft ha focalizzato sulla qualità del rendering, con un occhio di riguardo all'antialiasing. Prima notizia: da ora, il supporto dell'antialiasing 4x è obbligatori per i buffer a 32 bit (RGBA8) e 64-bit (RGBA16).

Microsoft ha cercato anche di razionalizzare la gestione dell'antialiasing offrendo più controllo ai programmatori e cercando di lasciare meno libertà ai produttori di GPU. Oltre ai livelli di anti-aliasing (2x, 4x, 8x), l'utente ha accesso al transparency antialiasing per filtrare le texture alpha sia in modalità multisampling che supersampling, e ognuna di queste modalità risponde a delle specifiche dipendenti dall'hardware: CSAA, CFAA, etc. Con le Direct3D 10.1, i programmatori possono finalmente specificare se vogliono un multisampling o un supersampling, garantendogli il controllo sui sample che vengono applicati agli shader

Infine, dove le Direct3D 10 abilitano l'accesso ai sample di un buffer colori multisampled, è ora possibile fare lo stesso in un multisampled depth buffer.

Come potete intuire sono diverse le novità apportate in queste nuove istruzioni introdotte da Microsoft DirectX 10.1 e dallo Shader Model 4.1.

I test condotti da noi in laboratorio hanno beneficiato dei seguenti driver:

- Nvidia Forceware 177.41 WHQL per sistema operativo Windows XP Professional 32 bit SP2.

Driver scaricabili da qui: http://us.download.nvidia.com/Windows/177.41/177.41_geforce_winxp_32bit_english_whql.exe- Nvidia Forceware 177.41 WHQL per sistema operative Windows Vista Ultimate 32 bit SP1.

Driver scaricabili da qui: http://us.download.nvidia.com/Windows/177.41/177.41_geforce_winvista_32bit_english_whql.exe- Per sfruttare la fisica della GeForce GTX 280, abbiamo usato i driver nVidia PhysX v. 8.08.01: http://www.2manydownloads.com/index.php?option=com_redirect&URL=http://www.tcmirror3.com/tcdownloads/nvidia/PhysX_8_08_01_driver.zip

Consigliamo sempre di installare i driver più recenti per la vostra scheda video Nvidia Geforce 9800GX2, purché essi siano certificati WHQL dalla stessa Microsoft.

Sistema di Prova e Metodologia di Test

Per il sistema di prova ci siamo avvalsi di una scheda madre prodotta dal noto costruttore ASUS equipaggiata con chipset Intel X48, in particolare è stata scelta il modello Foxconn Blackops nota per le sue particolari caratteristiche di Overclock ben spinte, oltre che per l’ottimo supporto alle nuove DDR3.

Come processore abbiamo usato un modello della INTEL appartenente alla famiglia dei Penryn, in particolare è stato scelto in modello Core 2 Duo E8600.

Il processore è stato messo a liquido, ed è stato usato il Waterblock By D-Tek Fuzion.

La scheda video è stata usata solo ed esclusivamente ad aria e con il suo dissipatore stock.

Le ram usate sono un Kit di DDR3 da 4Gb di capacità assoluta.

Tutti i test sono stati eseguiti con il sistema operativo Windows XP Professional 32 bit SP3 e Windows Vista Ultimate 32 bit SP1 senza particolari ottimizzazioni.

Un riassunto della configurazione di prova la trovare nella tabella sotto:

Normal 0 14 false false false IT X-NONE X-NONE MicrosoftInternetExplorer4

|

Configurazione sistema di prova |

|

|

Processore |

Intel Core 2 Duo E8600. |

|

Scheda madre |

Foxconn Blackops. |

|

Chipset |

Intel X48. |

|

Ram di Sistema |

2 x 2 GB G.Skill F3-12800CL7D-4GBHZ. |

|

Scheda Video |

Gainward GeForce GTX 280 |

|

Hard Disk |

Western Digital Raptor 36,7 Gb. |

|

Alimentatore |

Tagan TG1100-U95 1100-watt. |

|

Raffreddamento Cpu |

Liquid Cooled By D-Tek Fuzion. |

|

Sistema Operativo |

Windows XP Professional 32 bit SP2. Windows Vista Ultimate 32 bit SP1. |

|

Driver |

Nvidia Forceware 177.41 WHQL (Windows XP Professional). Nvidia Forceware 177.41 WHQL (Windows Vista Ultimate). nVidia PhysX v. 8.08.01 |

|

Monitor |

Eizo Hd2441w-Bk 24'' Lcd. |

|

Scheda audio |

Creative SB X-Fi Platinum Fatal1ty Champion. |

I test sono stati suddivisi in due tipologie differenti:

- Benchmark sintetici;

- Giochi.

Per i benchmark sintetici si è provveduto ad eseguire quattro tipologie differenti di test:

- Processore e scheda video a default, rispettivamente a 3.16 Ghz per il processore e 602/2214 per la scheda video.

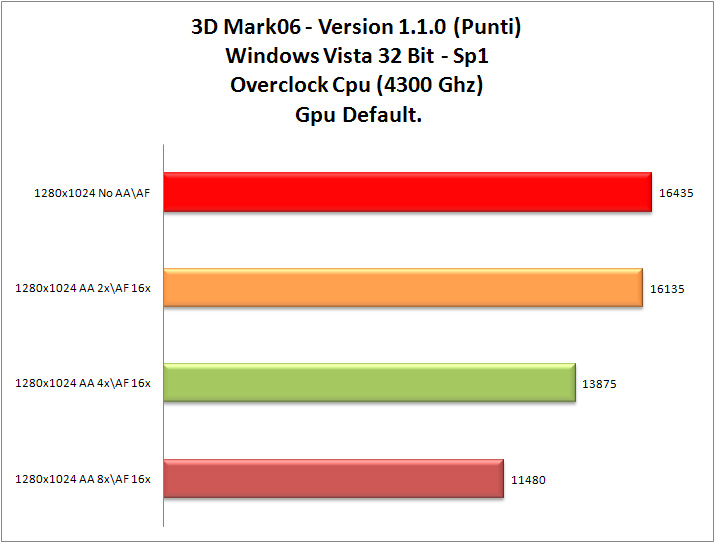

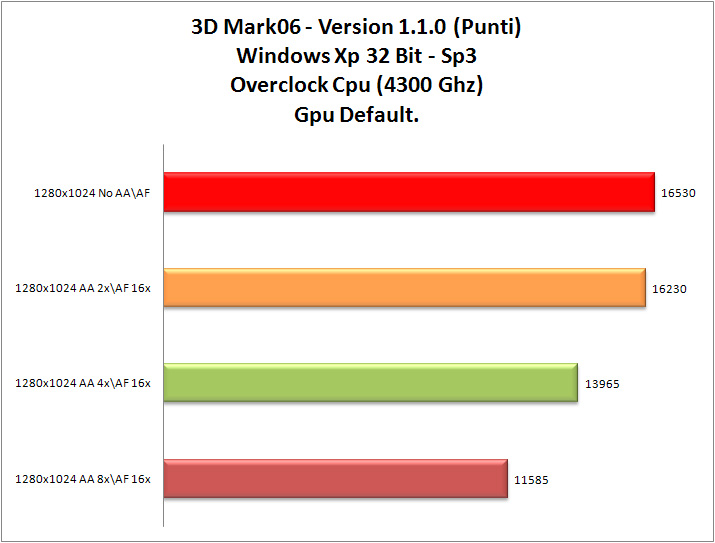

- Processore overclockkato alla frequenza di 4.30Ghz e scheda video a default (602/2214 Mhz).

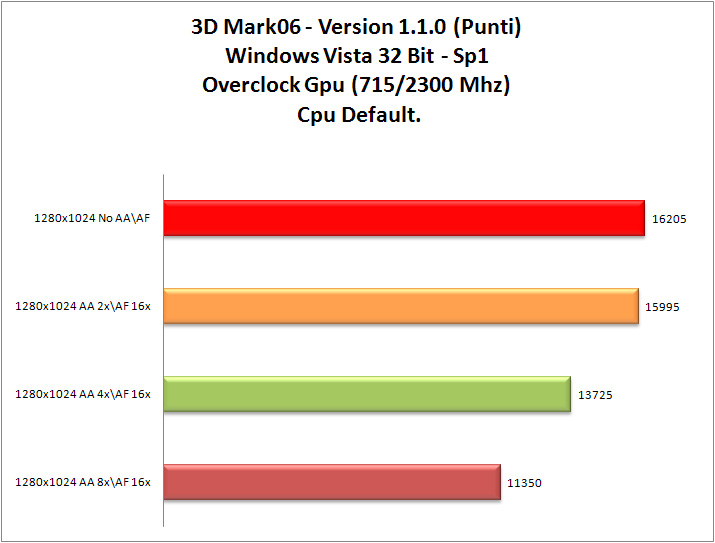

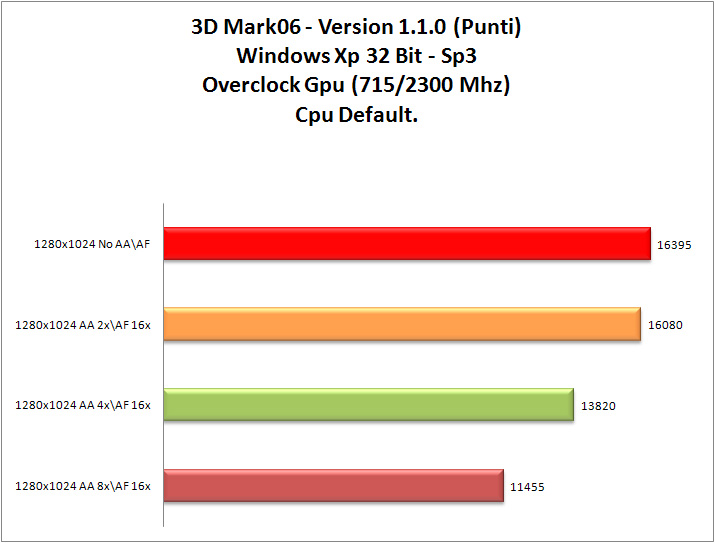

- Processore a default (3.16 Ghz) e scheda video overclockkata alla frequenza di 715/2300 Mhz.

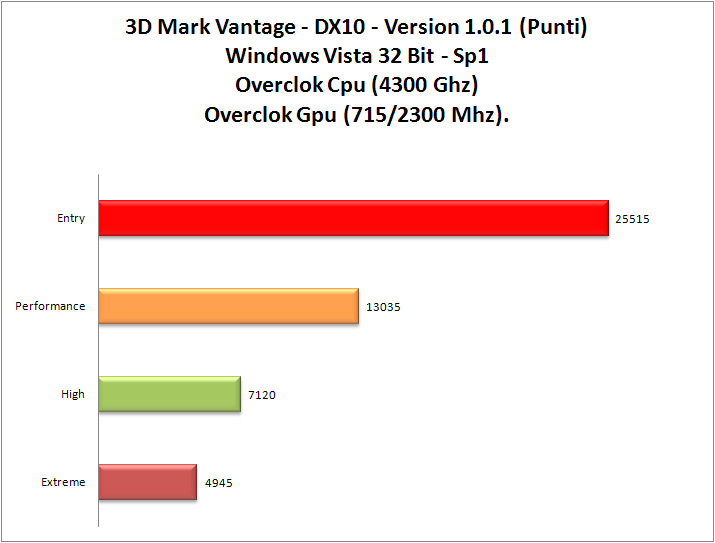

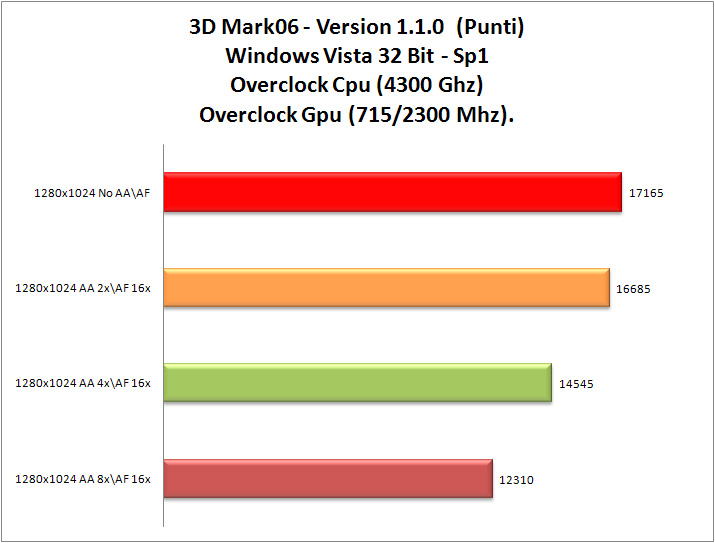

- Processore overclockkato alla frequenza di 4.30Ghz e scheda video overclockkata alla frequenza di 715/2300 Mhz. Frequenza facilmente raggiungibile e stabile, anche in abbinata al dissipatore stock.

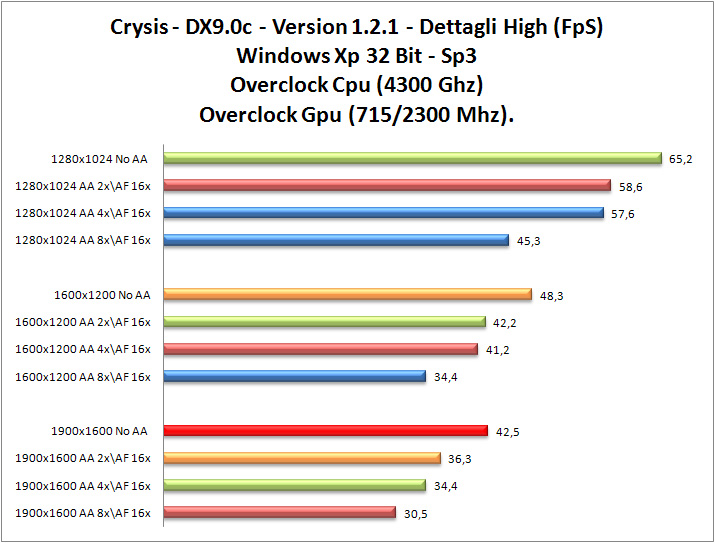

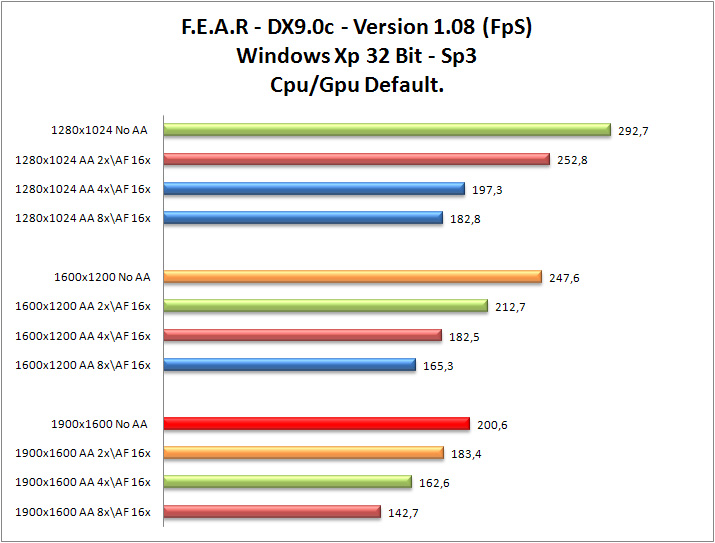

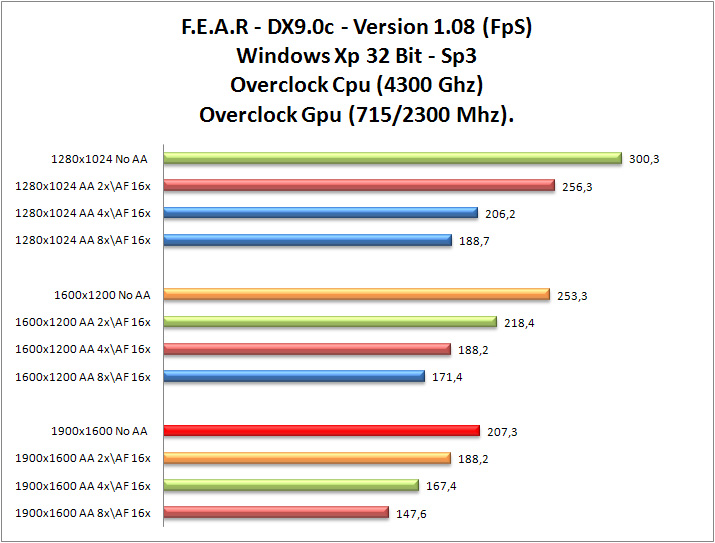

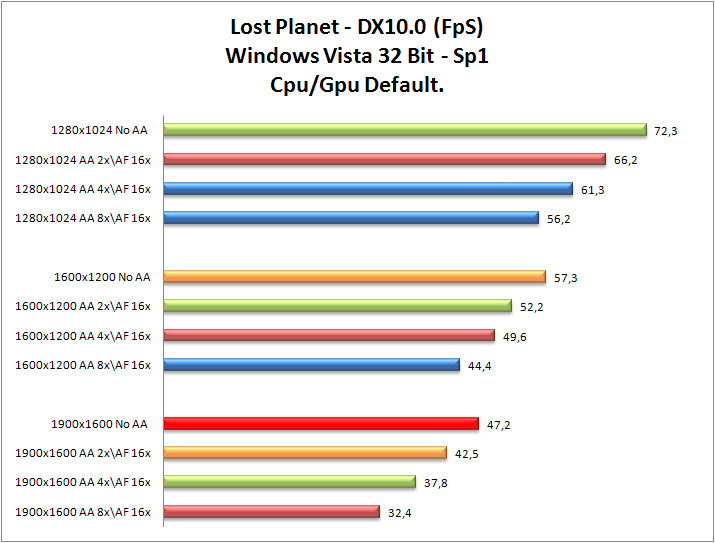

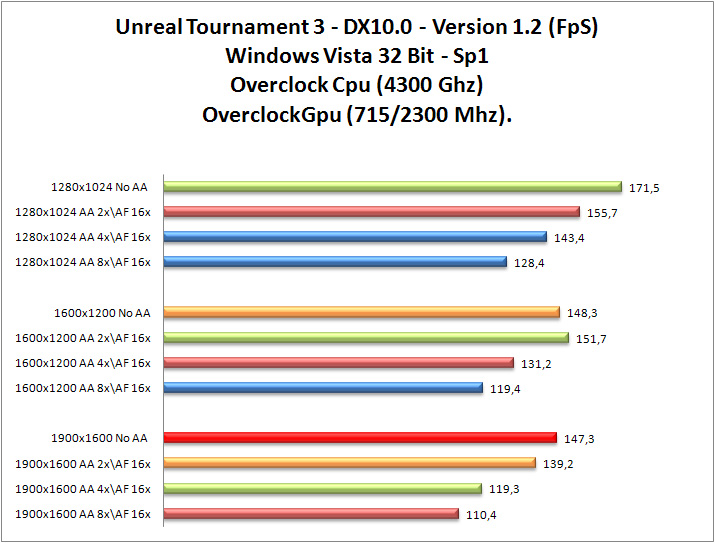

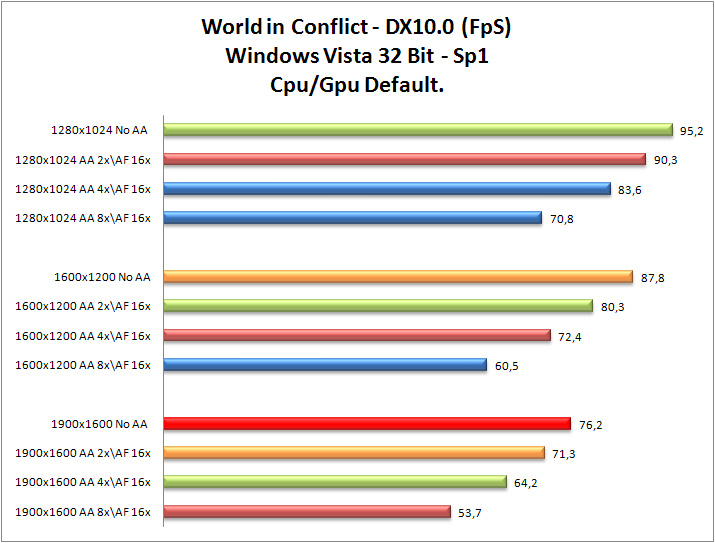

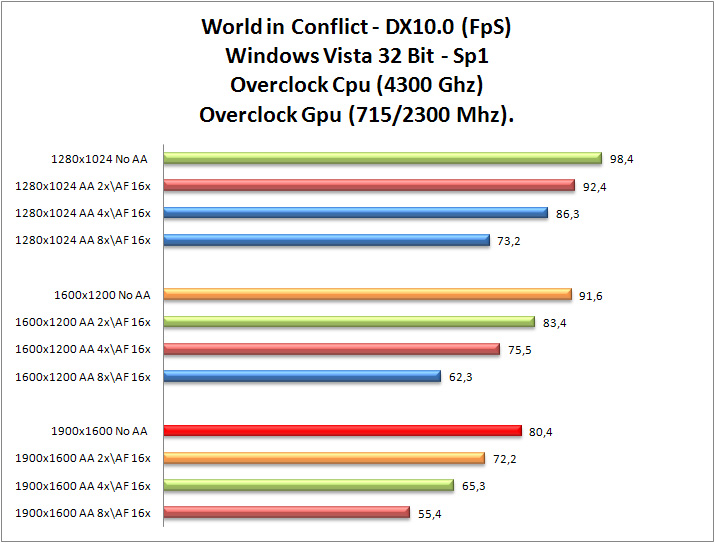

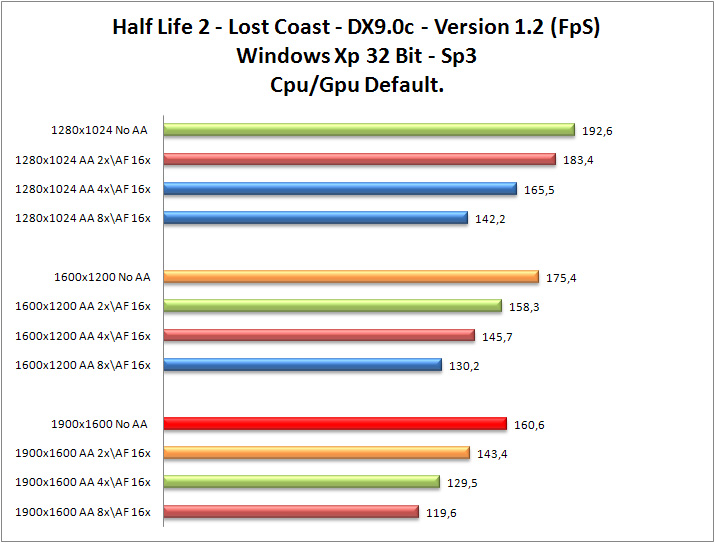

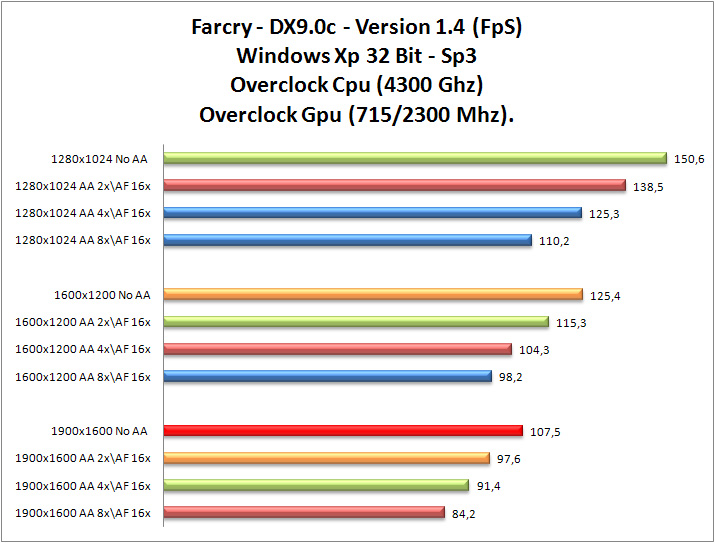

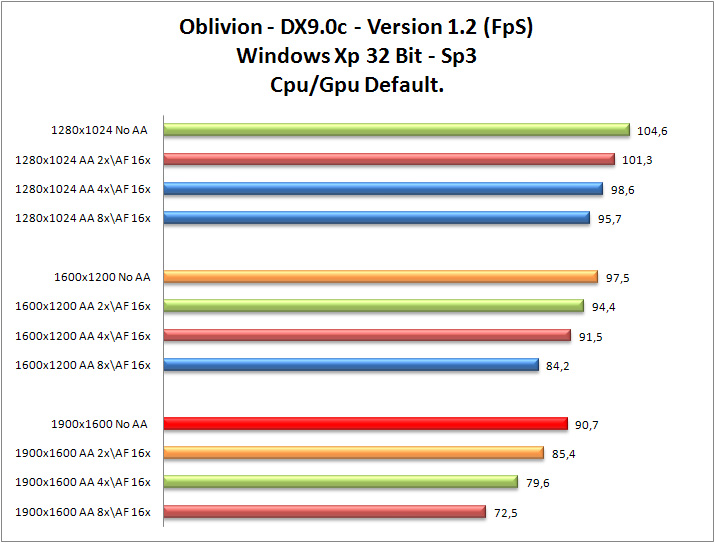

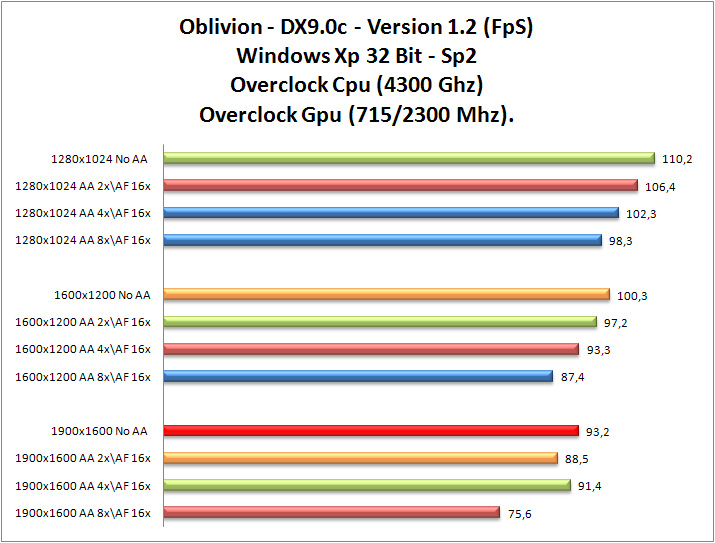

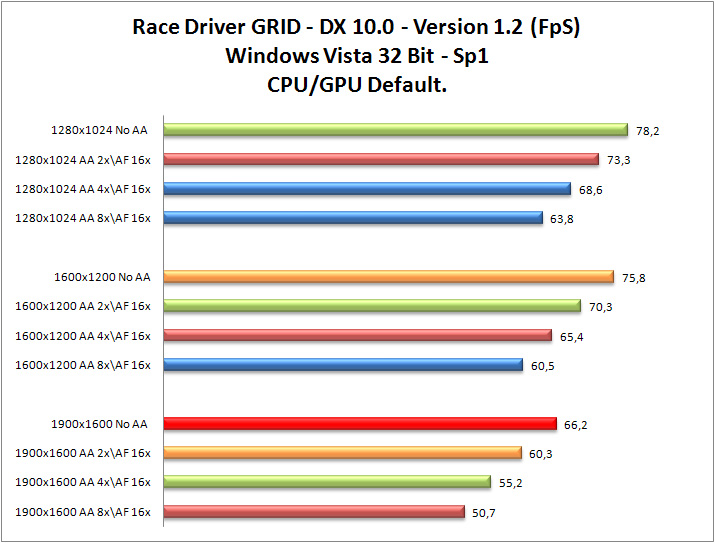

Per i giochi si è provveduto si è provveduto ad eseguire due tipologie differenti di test:

- Processore e scheda video a default, rispettivamente a 3.16 Ghz per il processore e 602/2214 per la scheda video.

- Processore overclockkato alla frequenza di 4.30Ghz e scheda video overclockkata alla frequenza di 715/2300 Mhz. Frequenza facilmente raggiungibile e stabile, anche in abbinata al dissipatore stock.

I test sono stati condotti su Windows Xp 32 Bit Sp3 ,per i giochi che non supportano le DX10 e con Windows Vista 32 Bit Sp1 per quelli che supportano le DX10.

Eccezione è stata fatta per il gioco Crysis, dove i test sono stati fatti sia in DX9 che Dx10, data la sua elevata pesantezza.

I test sono stati condotti tenendo invariato le seguenti impostazioni della scheda video:

- Texture filtering: Quality;

- Trilinear Optimization: Off;

- Vertical Sync: Always Off;

- Negative LOD bias: Off;

- AA-Mode: No AA, 2xAA, 4xAA, 8xQAA;

- Anisotropic Filter: No AF, 16xAF;

- MipMaps force: Off;

- Negative LOD bias: Off;

- Transparency AA: Off;

- Gamma-adapted AA: Off;

- Driver: - Nvidia Forceware 177.41 WHQL per il sistema operativo Windows XP Professional. - ATI Nvidia Forceware 177.41 WHQL) per il sistema operativo Windows Vista Ultimate e nVidia PhysX v. 8.08.01.

Si è deciso di procedere in questa maniera, al fine di dare le maggiori indicazioni all’utente finale sul comportamento del prodotto nelle diverse situazioni di utilizzo.

In fase di overclock è stato tenuto il dissipatore Stock presente sulla scheda video e non sono stai usati particolari sistemi aggiuntivi di raffreddamento. Tutti test sono stati condotti su un banchetto di prova e sono stati eseguiti più volte.

Si è provveduto ad usare il programma Rivatuner 2.10 per monitorare la temperature di esercizio della scheda , per variare la velocità della ventola e per effettuare l’ overclock della scheda video.

I test condotti sono stati realizzati sulle seguenti applicazioni:

Benchmark:

• 3DMark Vantage Version 1.0.1;

• 3DMark06 Version 1.1.0;

• 3DMark05 Version 1.3.0;

Giochi:

• Bioshock, D3D10, Version 1.1;

• Call of Duty 4, Version 1.5;

• Call of Juarez, D3D10, Version 1.1.0;

• Company of Heroes D3D10, Version 1.71;

• Crysis Version 1.2.1;

• F.E.A.R., Version 1.08;

• Lost Planet, D3D10, Patch D3D10;

• Stalker, Version 1.0005;

• Unreal Tournament 3, D3D10, Patch 1.2;

• World in Conflict, D3D10;

• Half Life 2- Lost Coast, Patch 1.2;

• Rainbow Six Vegas, Version 1.06;

• Prey, Patch 1.3;

• Assassin’s Creed Patch 1.2;

• FarCry, Patch 1.4;

• Oblivion, Patch 1.0.2;

• Race Driver GRID, Patch 1.2;

• Devil May Cry 4.

Benchmark

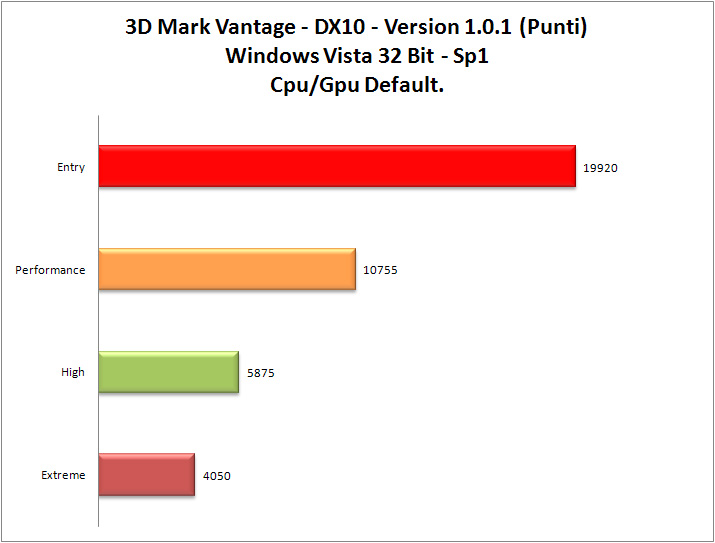

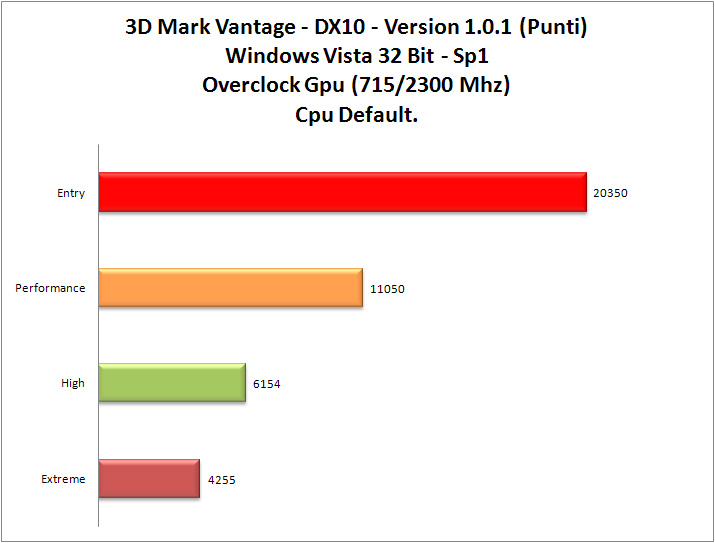

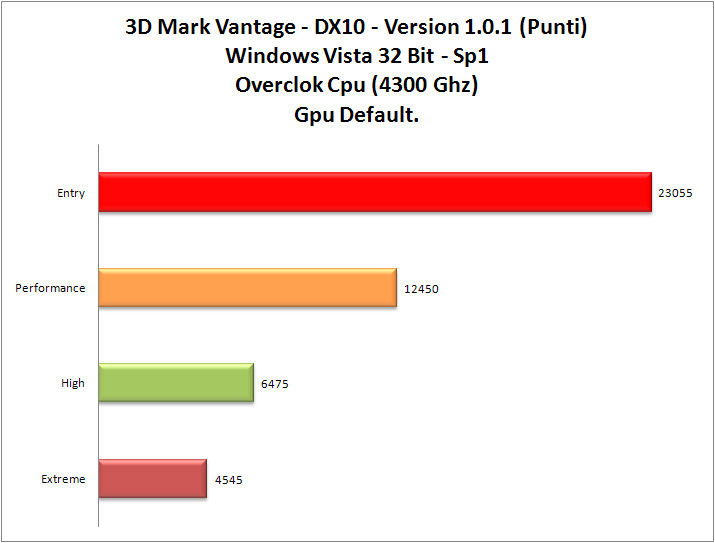

3DMark Vantage:

Il nuovo benchmark richiederà obbligatoriamente la presenza nel sistema sia di una scheda video con supporto alle API DirectX 10, che il sistema operativo Windows Vista; quest'ultimo è un requisito ovvio pensando al primo, in quanto è al momento attuale l'unico sistema operativo che supporta queste API e permette di sfruttare al meglio le potenzialità delle più recenti architetture video apparse in commercio.

Il benchmark si compone di 6 distinti test, 4 incentrati sulla GPU e 2 sulla CPU; i test sono eseguiti scegliendo tra 4 preset configurati da Futuremark, caratterizzati da un livello di carico di lavoro differente così da meglio riprodurre lo scenario tipico di utilizzo del proprio sistema a seconda del tipo di configurazione Hardware in uso.

3DMark Vantage introduce per la prima volta il concetto di preset; mentre nelle versioni precedenti vi era una singola configurazione, il nuovo software consente di impostare la configurazione Entry, Performance, High e Extreme, che contrassegneranno il punteggio con una lettera differente per ogni preset, rispettivamente E, P, H ed X.

Il test vengono fatti in modalità Entry, Performance, High e Extreme solo ed esclusivamente sotto Windows Vista 32Bit Sp1.

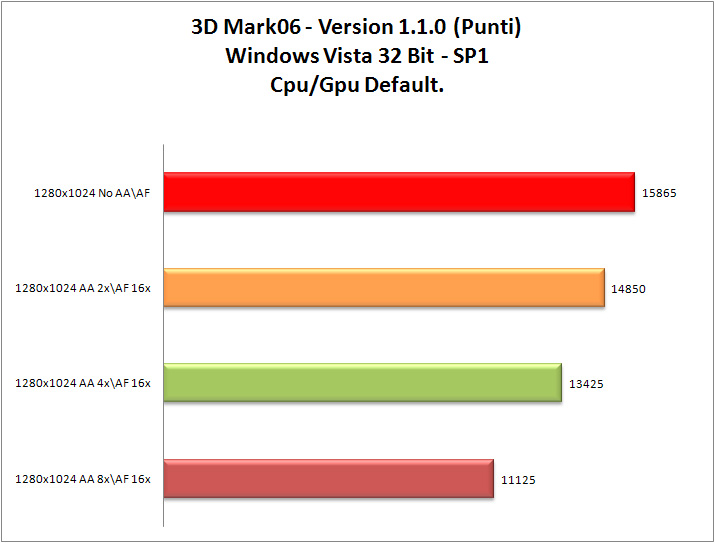

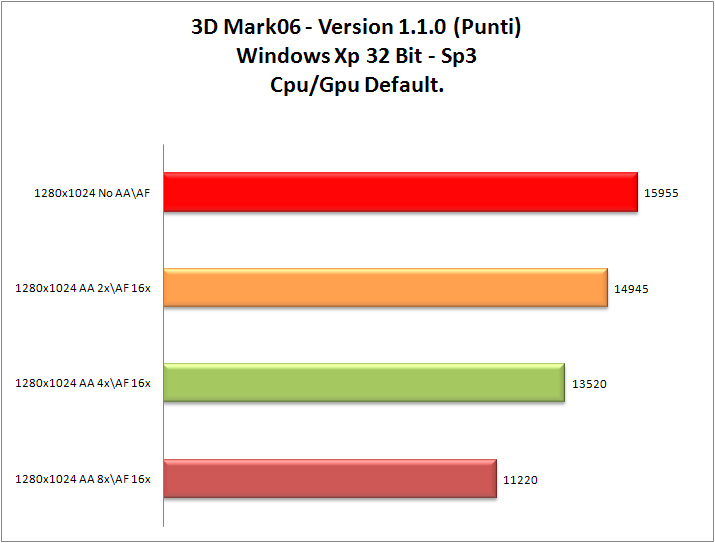

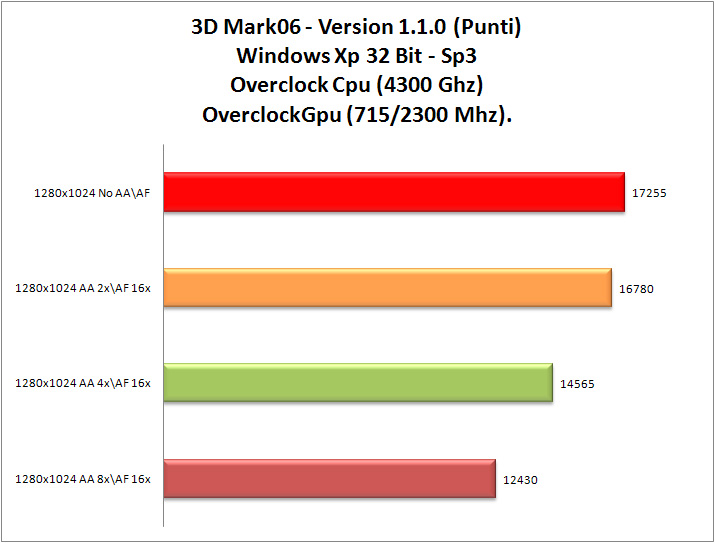

3DMark06

Il 3DMark06 è un programma di stress test principalmente per schede video, ma anche dell'intero PC. Infatti oltre a misurare le prestazioni del proprio computer con un punteggio finale, può essere utilizzato anche per controllare le temperature del sistema e per testare la stabilità in generale, anche a seguito di un overclock! La nuova versione del noto software di casa FutureMark trae origini dalla precedente versione dello stesso e necessita di un hardware di ultima generazione per poter essere quanto più obiettivo possibile nel metro di giudizio (per esempio evitando frequenti swapping del disco durante le fasi di test ed andandone ad inficiare i risultati) . La maggior parte dei test grafici sono stati ripresi dal 3DMark05 ed ulteriormente potenziati in quanto a gravosità di elaborazione e nuove funzionalità implementate. La principale differenza con la passata edizione sta nell’importanza conferita alla potenza di elaborazione del processore. Questo si basa sulla consapevolezza che la potenza delle GPU sta crescendo nel recente periodo con un passo più lungo di quello delle CPU, per cui con maggiore frequenza troviamo applicazioni CPU limited. Inoltre vi è da considerare quanto importante sta divenendo la CPU per l’elaborazione degli algoritmi della fisica dei corpi, della logica di gioco, dell’intelligenza artificiale, ecc.. Da qui la necessità di introdurre un doppio test specificatamente incentrato su questa tipologia di calcoli. Il punteggio del 3DMark06 è quindi il risultato della considerazione di GPU e CPU assieme e tende a valutare più come una piattaforma di calcolo sopporti un gioco futuro che a confrontare sottosistemi grafici tra loro. Altra differenza sta nella risoluzione usata come standard dal test (1280x1024 anziché 1024x768) e nella maggiore importanza conferita allo SM3.0, che secondo la casa sarà sempre più adoperato dai programmatori nei prossimi titoli ludici. Il 3DMark06 arriva con un doppio test centrato sullo SM2.0 e altrettanti test sullo SM3.0 e sull’HDR (High Dynamic Range). L’applicativo restituisce in output 3 sotto-punteggi: uno per lo SM2.0, uno per la CPU e l’ultimo per lo SM3.0.

Il test viene fatto alla risoluzione nativa di 1280*1024 sia sotto Windows Vista 32Bit SP1, che Windows XP 32 Bit SP3.

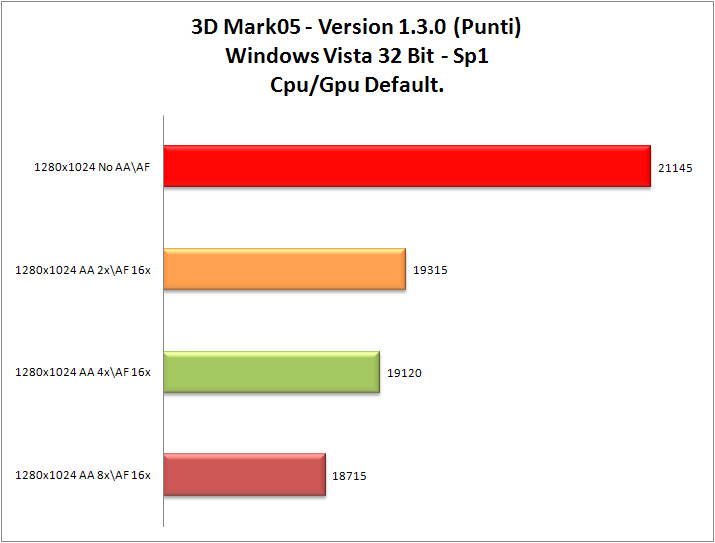

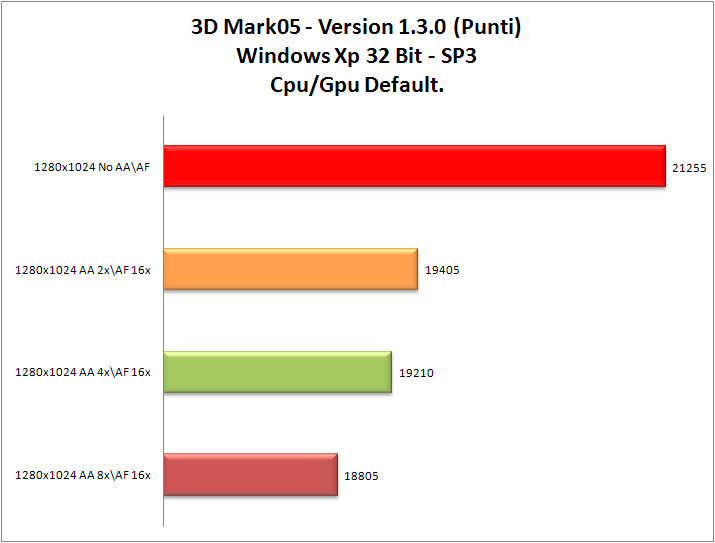

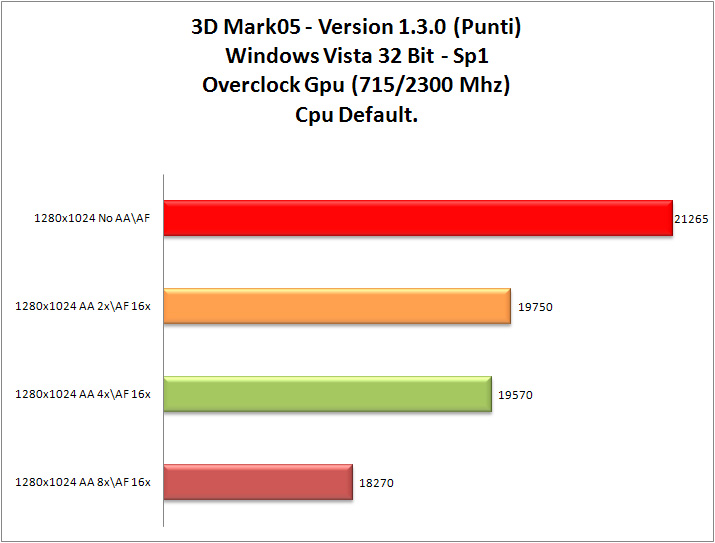

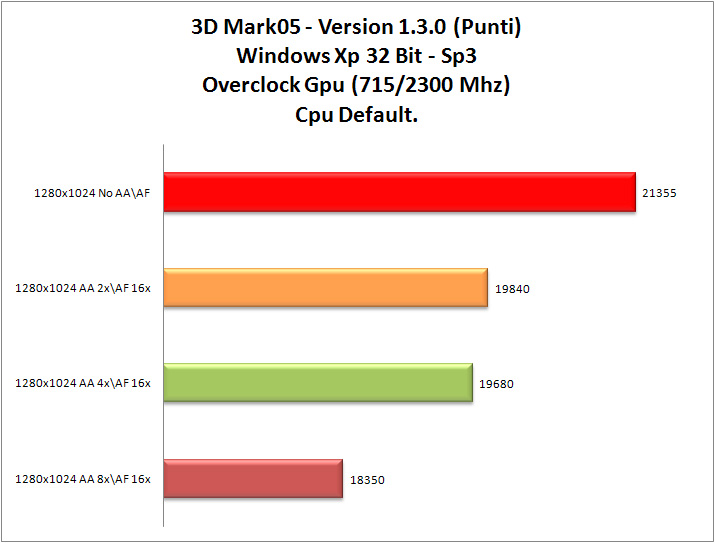

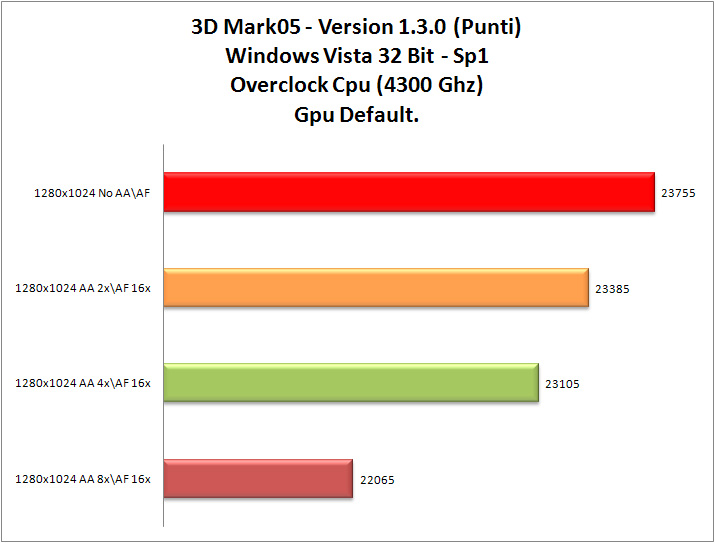

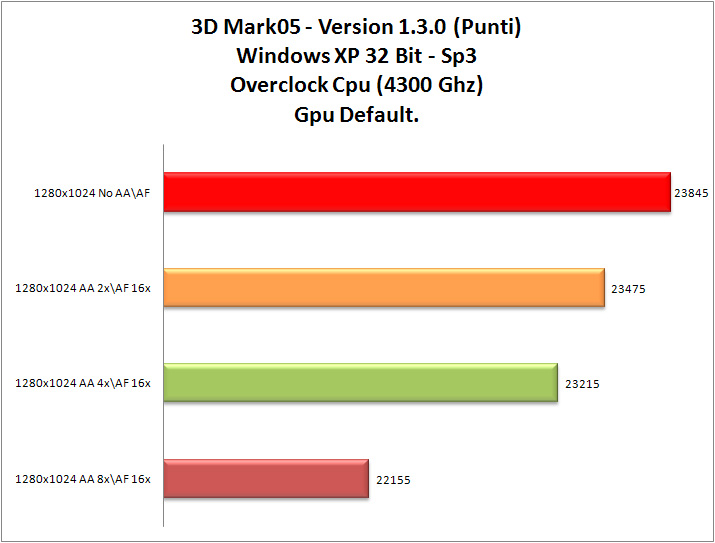

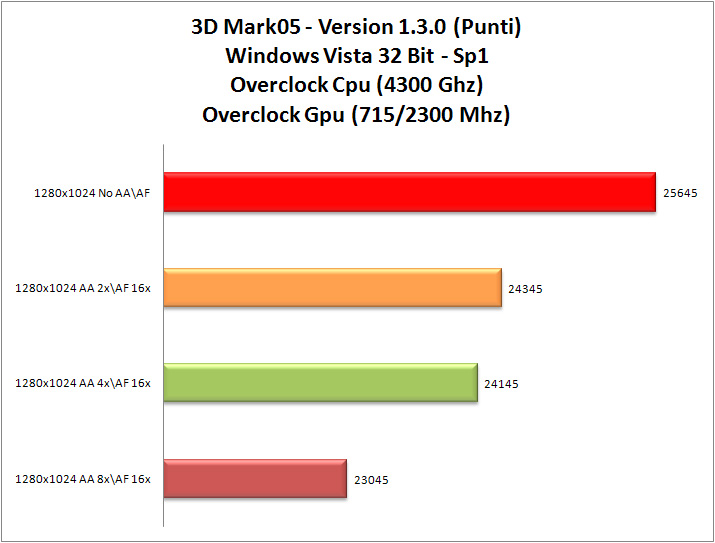

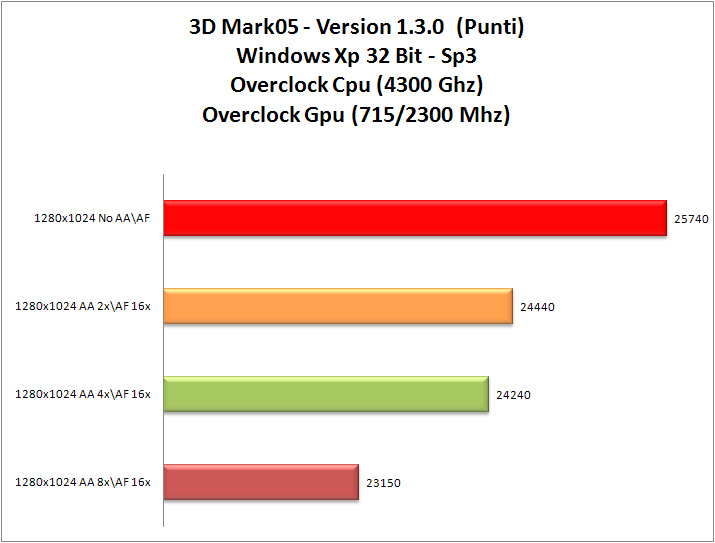

3DMark05

Il 3DMark05 è un programma di stress test per schede video .Basato sulle specifiche “DX9c”, questo test richiede la presenza di una scheda compatibile con le specifiche Pixel Shader 2.0 o superiori.Il test viene fatto alla risoluzione nativa di 1024*768 sia sotto Windows Vista 32Bit SP1, che Windows XP 32 Bit SP3.

(Grafico 3DMark05)

Considerazioni Benchmark

I risultati ottenuti in laboratorio con i vari Benchmark sintetici, ci portano a trarre della conclusioni molto interessanti. Chiaramente come si vede, i migliori risultati si ottengono con la scheda video e la cpu overclockkate. Interessante notare come la frequenza di funzionamento del processore incide solo ed esclusivamente quando vengono fatti i vari test senza AF (Anisotropic Filter) e AA (Antialiasing).

Questo è reso possibile dal fatto che la scheda video non dove applicare particolari filtri per migliorare la visualizzazione delle texture o attenuare le scalettature dei contorni delle immagini,potendo pertanto esprimere tutta la sua potenza, assecondata dal overclock della cpu (4.30Ghz), che diversamente risulta penalizzata alla frequenza base del processore di (3.16Ghz) generando colli di bottiglia che determinano cali prestazionali.

Sarebbe stato molto interessante analizzare le prestazioni ottenute con le cpu quadricore in modo da metterle in relazione con le cpu dualcore , al fine di rilevare, specialmente nel 3DMarck Vantage e nello 06 ,le differenze ottenute in termini prestazionali. Purtroppo al momento dei test, non avevamo disponibile una cpu quadricore. Ricordiamo che il 3DMarck Vantage e lo 06 sfruttano le cpu quadricore a differenza dello 05 che invece non le sfrutta.

Interessante notare come questi colli di bottiglia generati dal processore si assottigliano, andando quasi a scomparire, quando i vari test vengono fatti con AF (Anisotropic Filter) e AA (Antialiasing) attivi.

In questo coso, la scheda video nel dover applicare i filtri per migliorare la visualizzazione delle texture e attenuare le scalettature nei contorni delle immagini perde in prestazioni assolute,dovendo fare più calcoli, rendendo decisamente meno gravoso il lavoro della cpu.

Molto interessante è notare l’andamento prestazionale pressoché allineato che si ottengono tra i due sistemi operativi in prova, sinonimo che i driver per Windows Vista sono ben realizzati. Ricordiamo che un buon supporto da parte di driver in Windows Vista è fondamentale, visto la “pesantezza” del nuovo sistema di casa Microsoft, che causa cali prestazionali rispetto al fratello minore Xp.

Siamo rimasti molto soddisfatti delle prestazioni ottenute dalla scheda video, anche abilitando l’AF (Anisotropic Filter) e AA (Antialiasing), sinonimo che la scheda riesce a lavorare bene in modalità SLI con questi applicativi di Benchmark.

Molto interessante notare con nel test del 3DMark Vantage si ottenga un punteggio molto elevato grazie all’aiuto della fisica con i driver nVidia PhysX. Infatti il benchmark “Vantage”, sfrutta con un test la potenza della scheda fisica. La differenza in termini di prestazioni finali tra l’usare e il non usare l’nVidia PhysX n l test del “Vantage” è nell’ordine del 15% circa.

Giochi

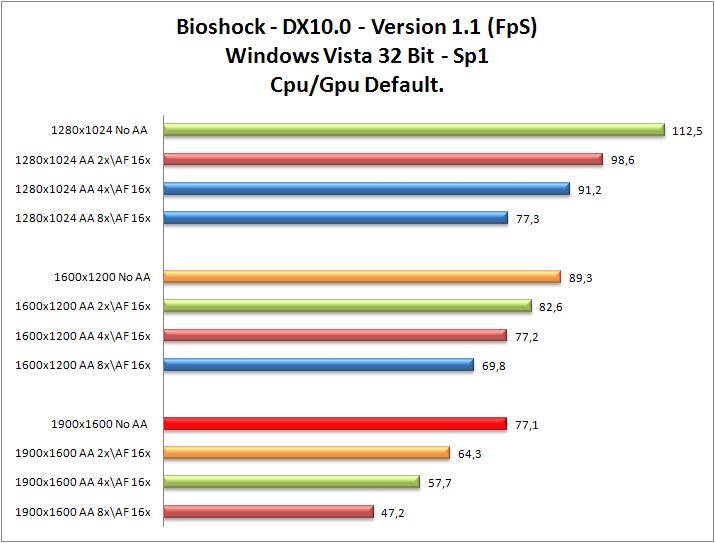

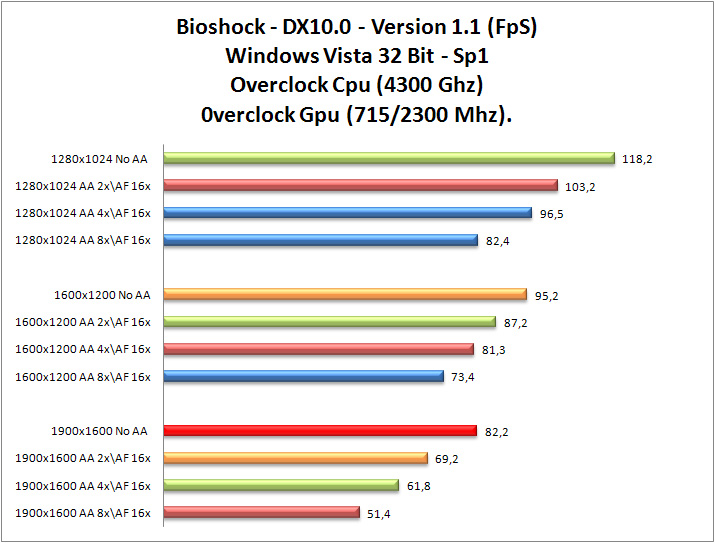

Bioshock

Dai creatori di System Shock 2 un terribile viaggio nelle profondità marine alla scoperta di Rapture, città utopia creata a difesa della società moderna, luogo ideale dove vivere. Ma qualcosa non va per il verso giusto e Rapture da paradiso diventa inferno. Non ci resta che sopravvivere. Il gioco supporta le DirectX 10.

(Grafici Bioshock)

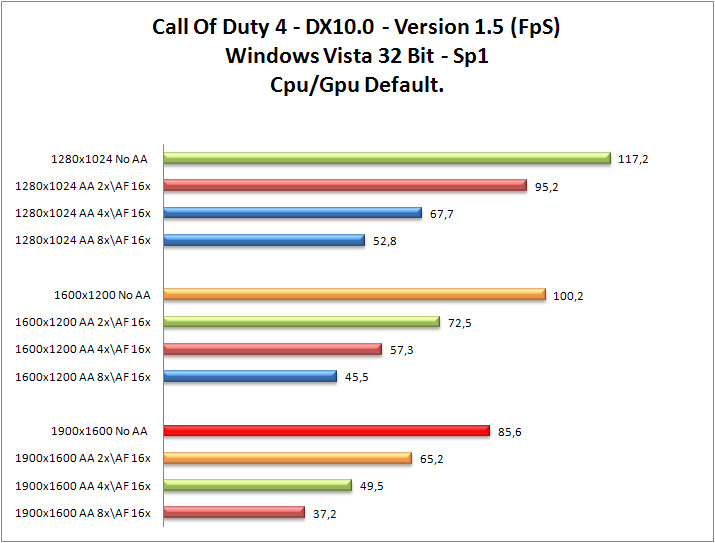

Call of Duty 4

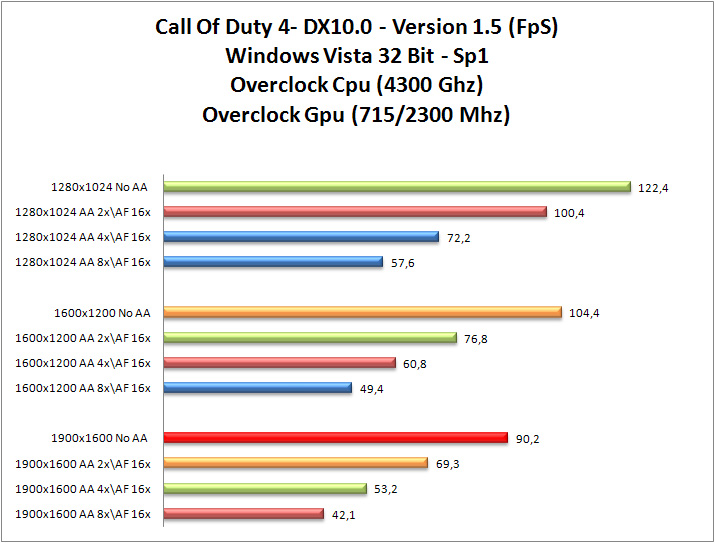

Call of Duty 4: Modern Warfare è il quarto capitolo della serie di Activision ed è uno sparatutto in prima persona di guerra. A differenza dei precedenti capitoli, dove il gioco ritraeva in tutti e tre gli episodi la seconda guerra mondiale, il gioco è ambientato in un periodo storico più vicino ai nostri giorni; questo capitolo è infatti dedicato alla guerra contro un ipotetica coalizione tra ultra-nazionalisti russi e terroristi islamici. Da qui la possibilità per i giocatori di utilizzare i soldati delle forze US Army, Marines e SAS (inglesi). Principalmente Call of Duty 4 è DirectX 9, ma sfrutta le librerie DirectX 10.

(Grafici Call of Duty 4)

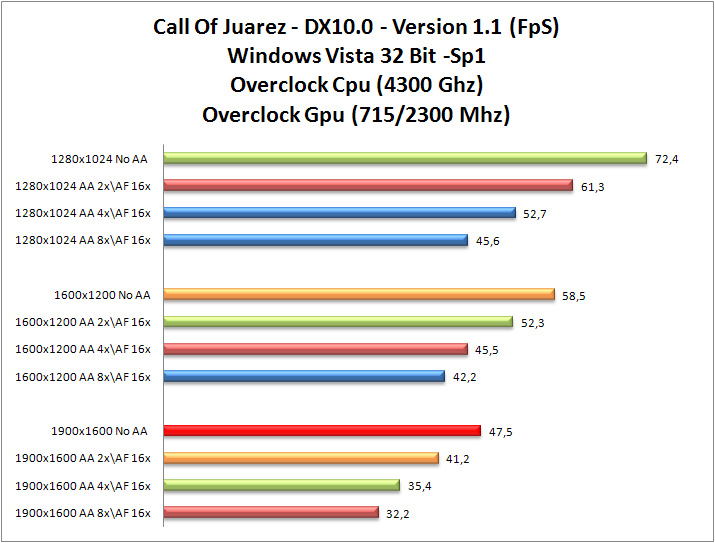

Call of Juarez

Il predicatore deve interrompere il suo sermone: qualcuno ha sentito colpi di pistola alla fattoria lì vicino. Qualcun altro dice di aver visto il suo giovane fratellastro in paese, dopo tanti anni di assenza. Tirare le somme è semplice: soprattutto quando il fienile comincia a bruciare e ci sono in terra i primi cadaveri. La parola passa subito alle pistole e la loro opinione è spesso definitiva. Il gioco supporta le DirectX 10.

(Grafici Call of Juarez)

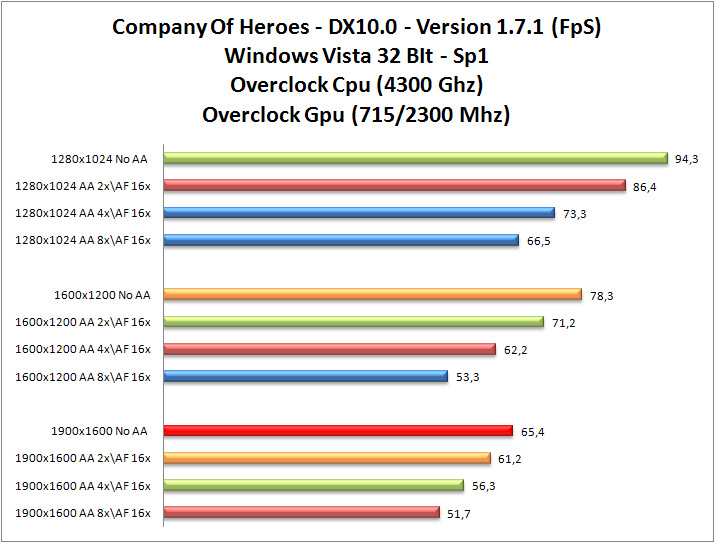

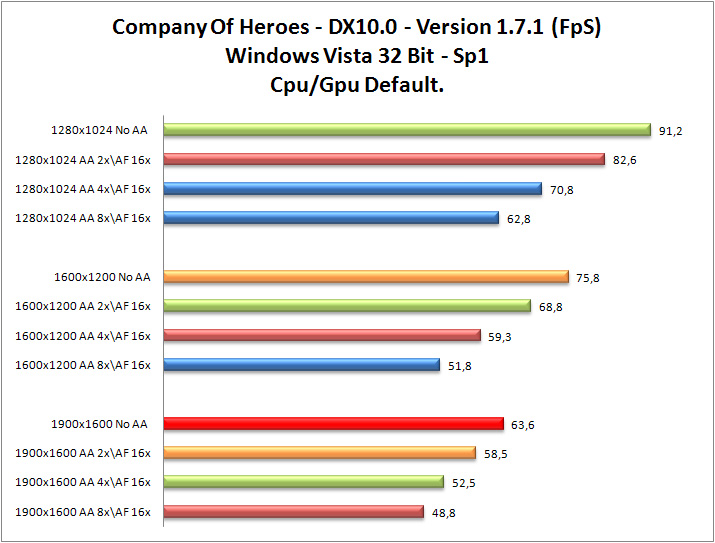

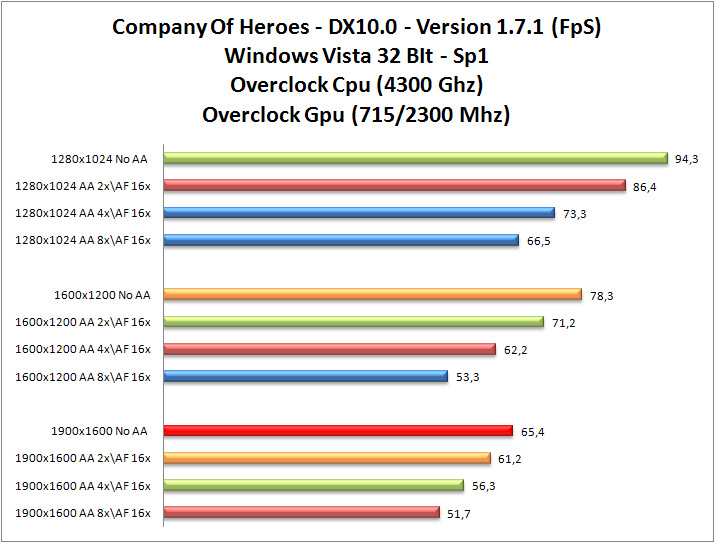

Company of Heroes

Dopo lo strepitoso successo di Homeworld, i ragazzi della Relic sono tornati per raccontarci la Seconda Guerra Mondiale attraverso gli occhi di un gruppo di soldati. Riuscirà Company Of Heroes a spodestare la serie Commandos dal trono di re degli strategici di guerra? Il gioco supporta le DirectX 10.

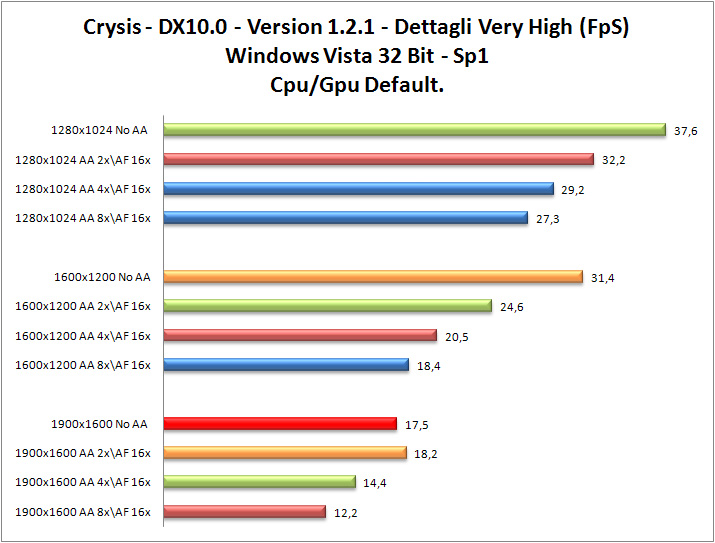

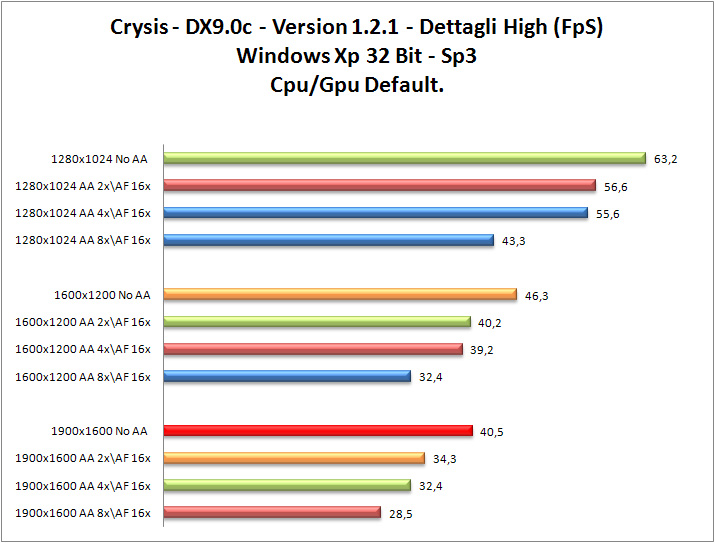

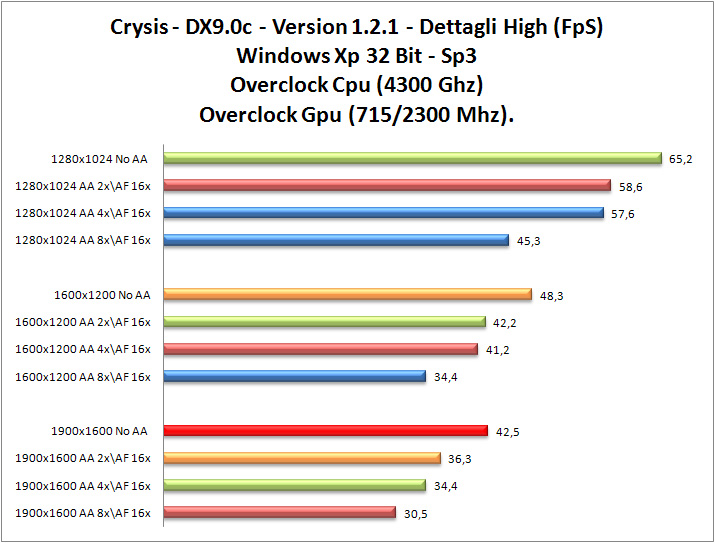

Crysis

Sparatutto in prima persona rilasciato nel Novembre 2007 dalla casa di sviluppo tedesca Crytek, già nota per la sua prima creazione, Far Cry, rivelatosi uno dei migliori giochi per computer del 2004 grazie al suo innovativo e potente motore grafico CryEngine, ora arrivato alla seconda generazione (CryENGINE2). Il gioco supporta le DirectX 10.

(Grafici Crysis)

F.E.A.R. - First Encounter Assault Recon

Sparatutto in prima persona con una trama a sfondo horror realizzato da Monolith Productions e distribuito da Vivendi nel 2005, titolo molto esigente che ha anche la possibilità di abilitare anche le softshadow che stressano ulteriormente il sottosistema video. Il gioco supporta le DirectX 9.0.

(Grafici FEAR)

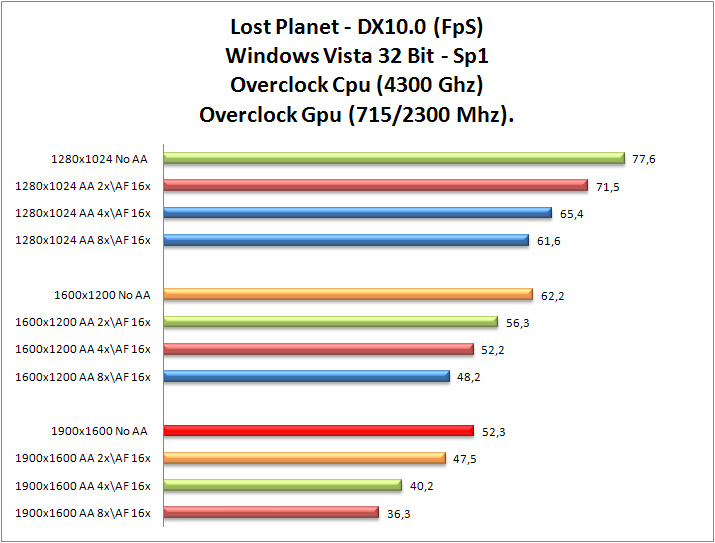

Lost Planet

Un pianeta inesplorato, le cui lande risultano fredde e ricoperte da una spessa coltre di ghiaccio e neve. Insetti dalle dimensioni agghiaccianti e pirati pronti a farci la pelle. Il gelo di Lost Planet sta per approdare da noi. Il gioco supporta le DirectX 10.

(Grafici Lost Planet)

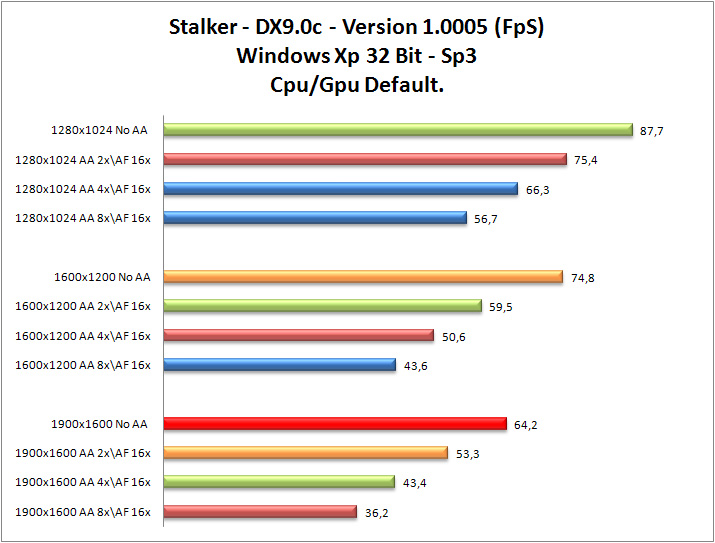

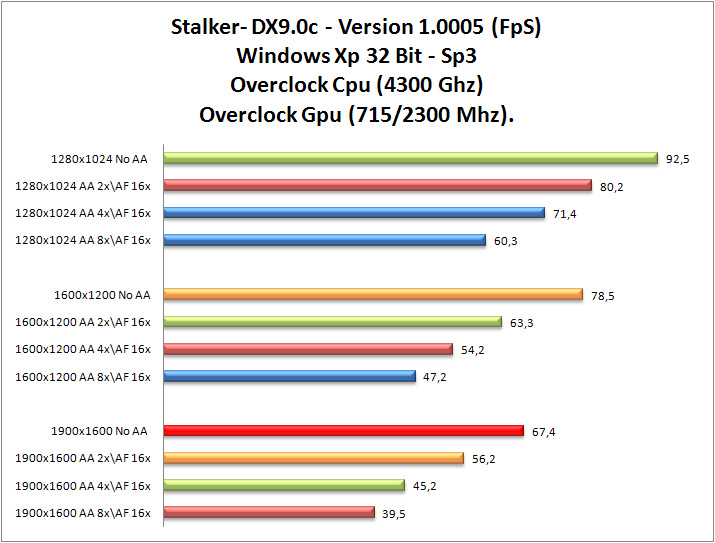

Stalker

Azione, atmosfera, sopravvivenza, misteri, orrore. La ricetta di S.T.A.L.K.E.R. sembra ben chiara e di sicuro successo; ma a volte, come la storia dei videogiochi insegna, anche i pronostici più sicuri possono essere ribaltati. Il gioco supporta le DirectX 9.0.

(Grafici Stalker)

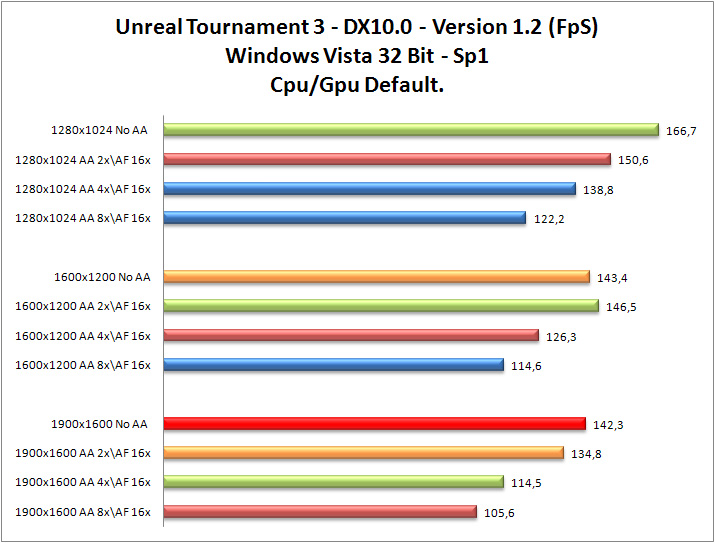

Unreal Tournment 3

Videogioco che utilizza il motore grafico Unreal Engine 3 ed è uno sparatutto in prima persona pensato principalmente per il multiplayer. Tuttavia in questo capitolo non è stata tralasciata la componente giocatore singolo. Il gioco supporta le DirectX 10.

(Grafici Unreal Tournment 3)

World in Conflict

Fantapolitica: testi nel quale si ipotizzano degli scenari geopolitici mai esistiti. Questa è la corrente letteraria alla quale si sono ispirati gli sviluppatori di World In Conflict, Massive Entertainment, per la creazione del loro super gioco. Si perché di questo si tratta: un titolo davvero ben fatto e carismatico, per gli amanti della strategia in tempo reale, ma non solo. Il gioco supporta le DirectX 10.

(Grafici World in Conflict)

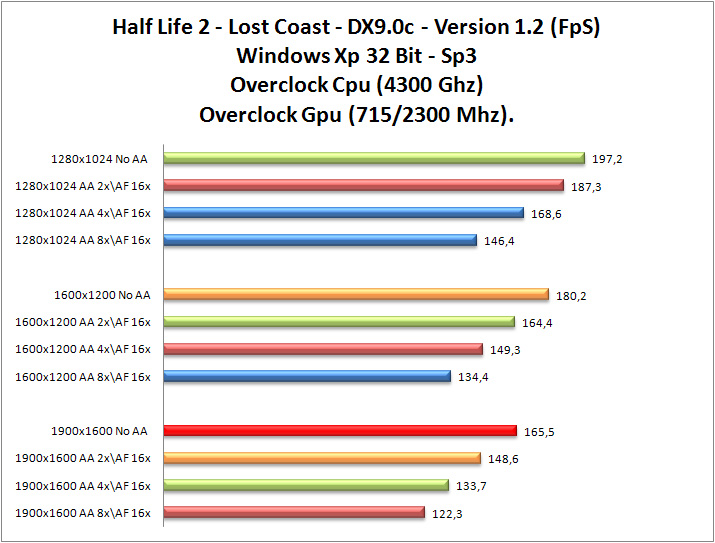

Half Life 2- Lost Coast

Half Life 2 prodotto da Valve sfrutta l’Engine Source per il rendering delle scene con la possibilità di abilitare anche l’HDR. Più che un nuovo livello è una specie di dimostrativo che mostra la spettacolarità del motore SOURCE su sitemi ultra pompati! Il gioco supporta le DirectX 9.0.

(Grafici Half Life 2- Lost Coast)

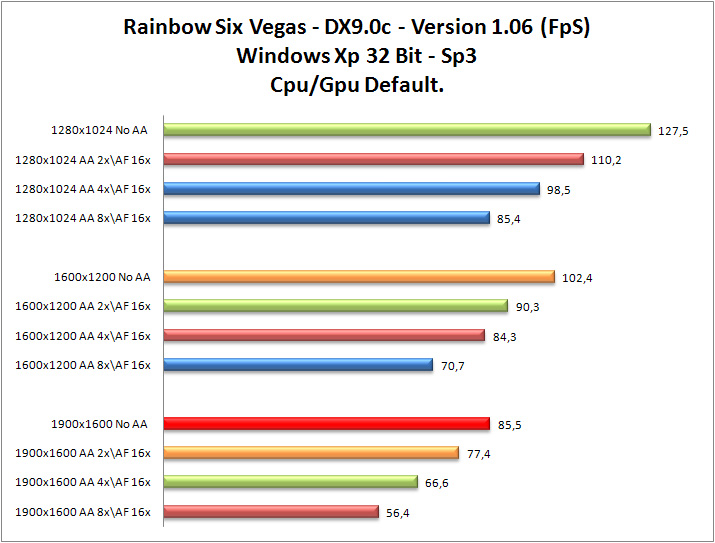

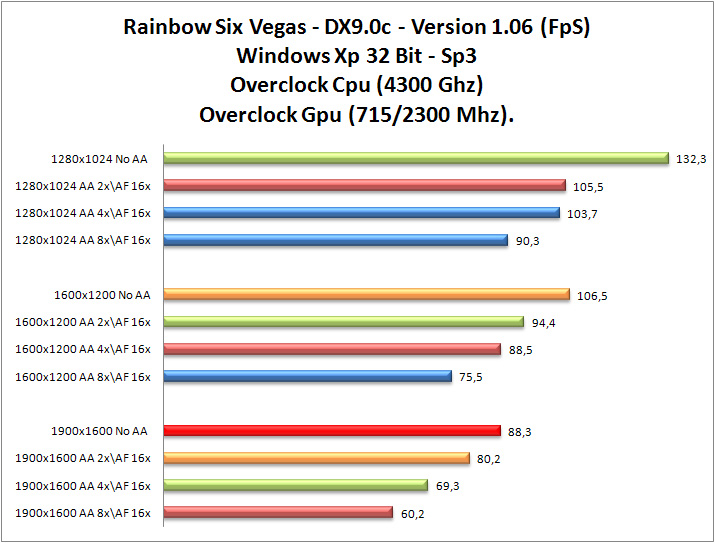

Rainbow Six Vegas

Il Team Rainbow debutta nel sistema di nuova generazione con il più coinvolgente capitolo del celebre sparatutto in prima persona. Gli agenti speciali del Team Rainbow vanno nelle strade caotiche di Las Vegas perché a Sin City un assedio terroristico di proporzioni crescenti minaccia di portare il terrorismo mondiale a livelli nuovi e incontrollabili.

Il futuro della sicurezza globale è in bilico mentre combatti per difendere le storiche ambientazioni di Las Vegas come Freemont Street, lo Strip e i casinò celebri in tutto il mondo. Vivi Las Vegas come mai prima d'ora, grazie alla rivoluzionaria tecnologia di nuova generazione mentre lotti contro il tempo per impedire la devastazione totale di una delle città più famose al mondo. Il gioco supporta le DirectX 9.0.

(Grafici Rainbow Six Vegas)

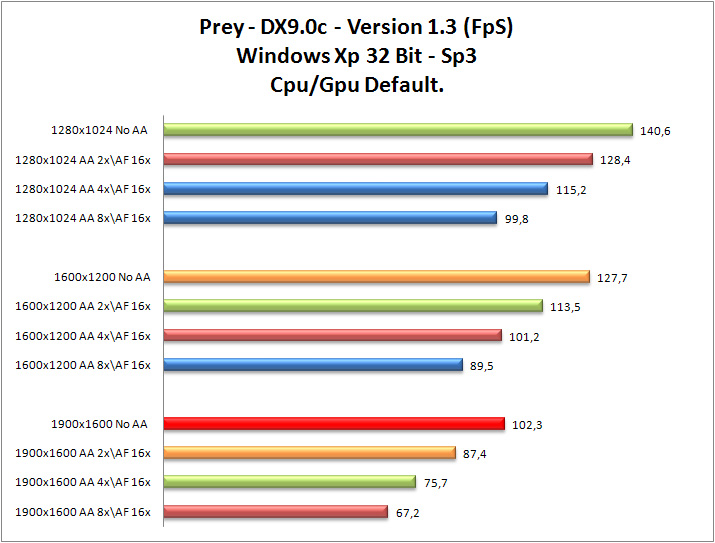

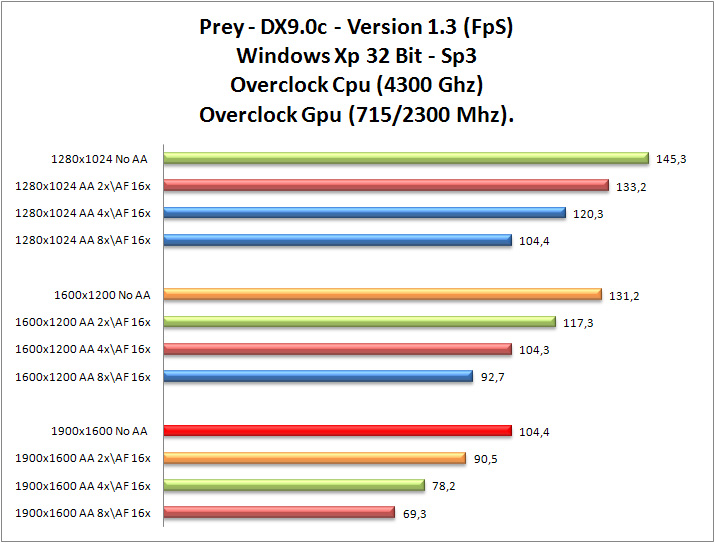

Prey

E’ un videogioco sparatutto in prima persona uscito nel 2006, sviluppato da Human Head e prodotto da 3D Realms. Inizialmente uscito per PC dotati di sistema operativo Windows XP, in seguito è stato convertito per XBOX 360 e Mac OS X. Prey è un gioco basato sullo stesso motore grafico di di DOOM 3 (Open GL). Il gioco supporta le DirectX 9.0.

(Grafici Prey)

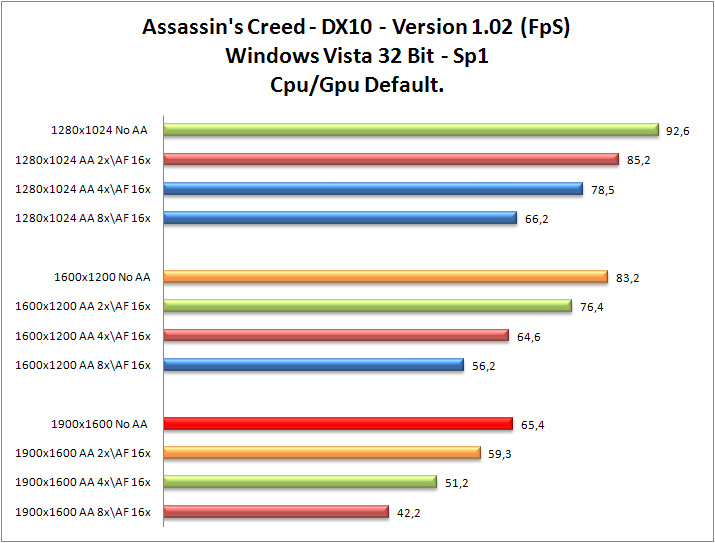

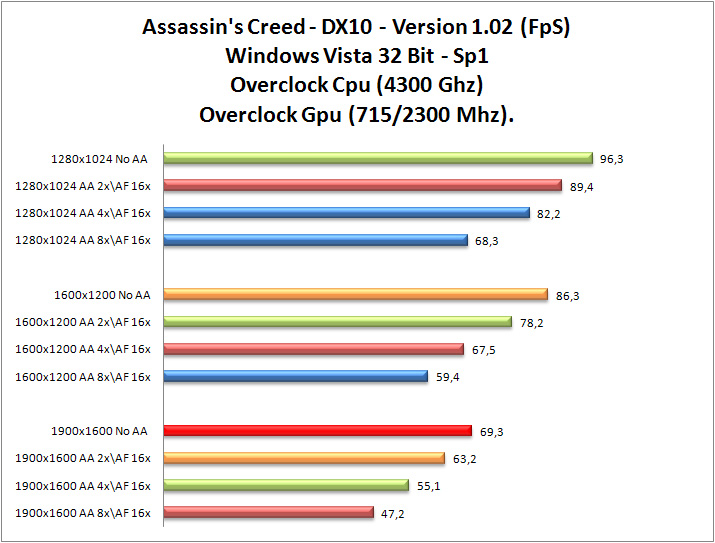

Assassin's Creed

E’ un videogioco sviluppato da Ubisoft di Montreal, gli stessi produttori di Prince of Persia. Assassin’s Creed è ambientato nel 1191 d.C., periodo storico nel quale la Terra Santa è devastata dalla Terza Crociata. La vittoriosa campagna in Terra Santa di Riccardo Cuor di Leone fece in parte dimenticare le sconfitte di alcuni anni prima e attraverso una saggia tregua i pellegrini cristiani ebbero il permesso di visitare Gerusalemme, che restava comunque in territorio musulmano. Questo fu uno degli eventi che più contribuirono ad innalzare la fama di Saladino come condottiero leale e onesto. Nascosti nella segretezza dei loro rifugi e temuti per la loro ferocia, gli Assassini intendono fermare la guerra eliminando i principali attori delle fazioni in conflitto. I giocatori assumono il ruolo di Altaïr Ibn La-Ahad (aquila in volo e figlio di nessuno), un adepto della setta, che padroneggiando alla perfezione le antiche arti della destrezza e dell'assassinio, dovrà gettare nel caos le città nelle quali sono ambientate le missioni del gioco. Altaïr è stato privato dell'anulare della mano sinistra per poter utilizzare al meglio la sua arma: la lama nascosta. Il meccanismo applicato nel braccio gli permette di eliminare le vittime facendo passare una lama nascosta nella manica attraverso un meccanismo a scatto. Inoltre il suo abito bianco lo aiuta a mimetizzarsi meglio tra la folla e, in particolar modo, tra gli eruditi di un tempo, grazie al suo grande cappuccio. Altair si ritrovera ad affrontare, (oltre ai propri bersagli), i Crociati, gli Ospitalieri, i Templari, i Teutonici, i Saraceni, e ovviamente le Guardie Cittadine.Tutti i bersagli di Altaïr sono personaggi che sono veramente morti o scomparsi nel 1191, (ma non necessariamente assassinati). Il gioco supporta le DirectX 10.1

(Grafici Assassin's Creed)

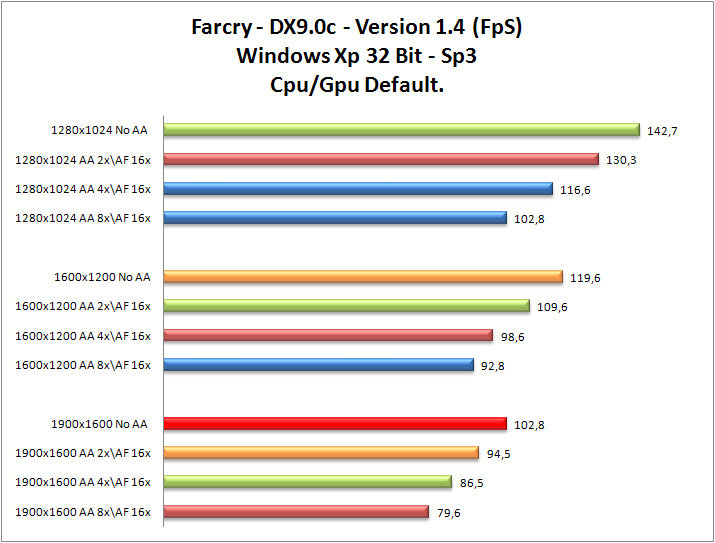

FarCry

Far Cry è uno sparatutto in prima persona sviluppato da Crytek e pubblicato da Ubisoft. In Far Cry il giocatore vestirà i panni dell'ex membro delle forze speciali dell'esercito statunitense Jack Carver. Far Cry è passato però alla storia soprattutto grazie al suo motore grafico, il CryENGINE sviluppato da CryTek. All'epoca della sua uscita, infatti, la grafica di Far Cry era quanto di meglio si fosse mai visto, capace di riprodurre la vegetazione e, soprattutto, l'acqua, con una qualità al limite del fotorealismo. Le isole su cui ogni livello era ambientato erano gigantesche, ed il giocatore godeva di una libertà quasi assoluta, potendole esplorare come preferiva. Anche i nemici erano, all'epoca, i più intelligenti mai visti in uno sparatutto: per la prima volta gli avversari controllati dal computer non partivano alla carica come dei pazzi suicidi, e per la prima volta si vedevano nemici che tentavano di aggirare il giocatore e prenderlo alle spalle, e spesso ci riuscivano. Il gioco supporta le DirectX 9.0.

(Grafici FarCry)

Oblivion

Oblivion è il quarto capitolo della saga The Elder Scrolls, sviluppata da Bethesda Softworks ed iniziata nel 1994 con The Elder Scrolls - Arena. Si tratta di un gioco di ruolo nel quale si deve salvare il regno di Tamriel da una oscura congiura che, dopo aver assassinato l'imperatore, tenta di far tornare le forze del male nel mondo reale dall'inferno, l'Oblivion appunto. Il giocatore può creare il proprio personaggio in molti modi diversi che influenzeranno il modo di affrontare l'avventura . Il gioco supporta le DirectX 9.0.

(Grafici Oblivion)

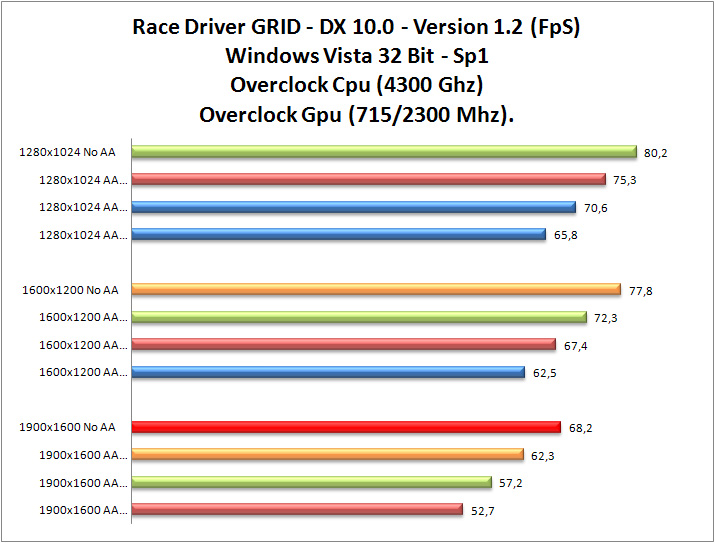

Race Driver GRID

Nuovo titolo di corse, basato sul motore grafico e fisico di Colin McRae Dirt. Precedentemente conosciuto come Race Driver One, questo gioco è basato sulle corse su asfalto (circuiti cittadini o vere e proprie piste realmente esistenti) e non nasconde una natura piuttosto arcade.

GRID si focalizza su tutto quello che accade fra la partenza e l’arrivo di una gara: gli aspetti drammatici, le rivalità, le aggressioni (!) e gli incidenti. Fra i punti di forza troveremo il sistema di danni, l’intelligenza artificiale e un’atmosfera come mai vista prima in un gioco di guida. . Il gioco supporta le DirectX 10.0.

(Graici Race Driver GRID)

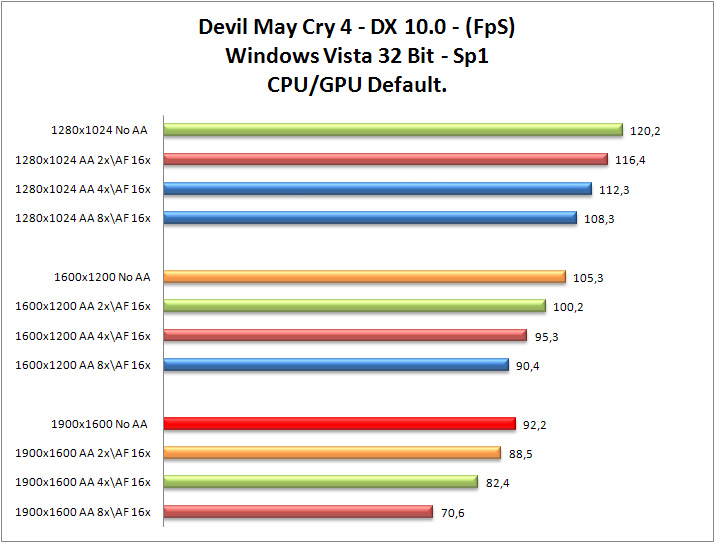

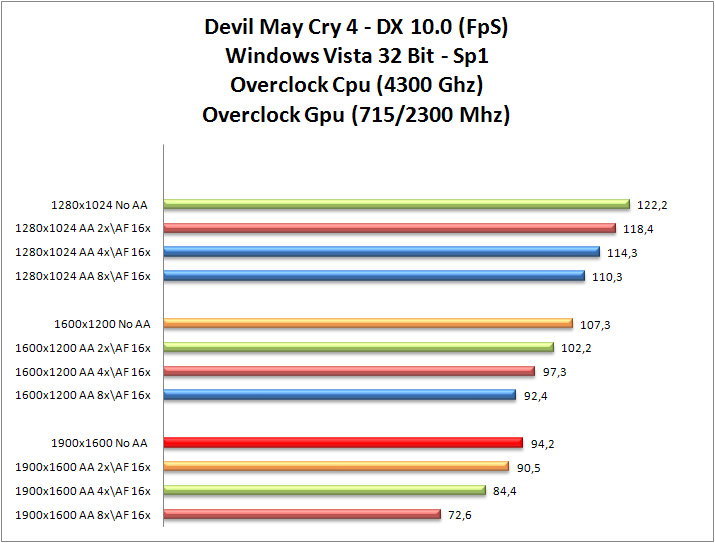

Devil May Cry 4

Devil May Cry 4 è una serie Horror che, fin da primo episodio realizzato nel 2001, ha riscosso un grandissimo successo di pubblico tanto che tutti aspettavano con trepidazione un nuovo episodio che puntualmente è stato rilasciato dalla Capcom. A differenza dei tre episodi precedenti, in Devil May Cry 4 vestirete i panni di Nero, un misterioso personaggio dal passato oscuro che nasconde un braccio mostruoso che rivela la sua natura demoniaca.

Vi troverete catapultati nella città di Fortuna dove il potere è in mano ad una casta conosciuta con il nome di “ordine della spada”. Tutti venerano l’ordine e lo difendono dai possibili nemici. Accade un giorno (così ha inizio la vostra avventura) che, durante una importante cerimonia, il leader dell’Ordine venga ucciso da un misterioso uomo. Il vostro compito sarà quello di combattere il nemico e di scoprire il motivo del suo folle gesto….

Per i nostri test abbiamo utilizzato il benchmark incluso nella demo; riportando il framerate medio di tutte le 4 scene proposte. Le scene differiscono per la tipologia di ambiente, numero di nemici e interazioni tra i vari soggetti in campo, coprendo quasi completamente tutte le ambientazioni presenti nel titolo finale.

Il gioco supporta le DirectX 10.0.

(Grafici Devil May Cry 4)

Considerazioni Giochi

La nuova Nvidia Geforce GTX 280 è in grado di far girare senza alcun problema, in maniera molto soddisfacente, la quasi totalità dei giochi presenti attualmente in commercio.

Grazie all’elevata potenza di calcolo del GT200, possiamo, permetterci tranquillamente di applicare filtri come l’anisotropic e l’ adaptive Anti-Aliasing, anche per risoluzioni elevate di 1900x1200.

La scheda video, è in grado di far girare in maniera soddisfacente a risoluzioni alte e applicando alcuni filtri filtri anche per il gioco “Crysis”.... specialmente in DX9.0,arranca ancora invece in DX10, specialmente se si mettono i filtri. Sappiamo tutti che il gioco “Crysis”, non è s stato programmato in maniera ottimale, infatti risulta molto poco scalabile.

Nel complesso siamo rimasti molto soddisfatti della scalabilità e potenza dimostrata dalla scheda in tutte le situazioni.

Overclock Gainward GeForce GTX 280

Aspetto molto importante per gli smanettoni, è rappresentato dalla possibilità di Overclokkare un componente. Ebbene, anche sotto questo punto di vista la Gainward GeForce GTX 280 non ci deluderà.

Dalle prove condotte in laboratorio, la scheda è stata in grado di reggere senza problemi e in piena stabilità le frequenze rispettivamente di 715Mhz per il core e 2200Mhz per le ram, senza generare alcun tipo di antefatto, anche dopo diverse ore di utilizzo intensivo sotto pesante stress con il semplice dissipatore stock presente sulla scheda video.

Tutto questo è stato reso possibile grazie al buon studio da parte di Nvidia nell’ottimizzazione dei flussi d’aria del dissipatore.

Siamo stati in grado di chiudere sessione di Benchmark alla frequenza di 740/2410 senza chiaramente avere la massima stabilità operativa.

Possiamo ritenerci più che soddisfatti da quanto siamo riusciti ad ottenere con un dissipatore stock.

Purtroppo queste grandi doti di Overcloccabilità della scheda, sono in parte vanificate dalla non facile rimuovere il dissipatore che ricopre interamente la GPU.

E’ possibilein maniera molto semplice, poter usufruire di altri metodi di dissipazione decisamente più spinti quali liquido o Azoto, al fine di incrementare le frequenze di funzionamento della scheda , senza causare la perdita della garanzia della stessa.

Rumorosità e Consumi

Il dissipatore durante i nostri test, non si è mai rilevato eccessivamente rumoroso, la copertura metallica, abbinato al basso regime di rotazione della ventola, ha permesso un buon comfort acustico. Le temperature in idle sono però decisamente elevate, ben 70° C. In full load si raggiungono facilmente i 90° C. Una temperatura così elevata può quindi causare problemi di riscaldamento dell'intero sistema se non correttamente areato e portare pertanto a fastidiosi blocchi di sistema.

La scheda è progettata per lavorare fino alla temperatura di 105°C, oltre questa soglia, la scheda entra in modalità protezione downcloccando le GPU.

La ventola è termoregolata, il profilo attivo con i driver 177.41 è piuttosto conservativo e non la spinge mai alle velocità più alte, gli appassionati potranno regolarla a piacere con il software nTune di NVIDIA o con Riva Tuner 2.10.

La ventola, se impomatata manualmente a pieno regime,ovvero al 100%, risulta essere molto rumorosa e fastidiosa,tanto da superare i 65 db di rumorosità.

Un buon compromesso, prestazioni/rumorosità si ottiene impostando la velocità di rotazione della ventola al 50%.

Dal punto di vista dei consumi, la Geforce GTX 280 si è comporta piuttosto bene, il passaggio ad una tecnologia di produzione inferiore ai 65 nm avrebbe decisamente aiutato, infatti siamo intorno ai 490w “CPU+GPU” sotto stress.

Conclusioni

| Prestazioni : | |

| Rapporto qualità/prezzo: | |

| Complessivo : |

La Gainward GeForce GTX 280, è una scheda indirizzata al mercato Enthusiast, rivolta a tutte quelle persone che voglio il massimo senza compromessi.

La VGA si è rivelata estremamente veloce ed è adatta per giocare ad altissime risoluzioni senza cali di frame rate, a tutte le risoluzioni e con qualsiasi impostazione usata,con tutti i più recenti videogiochi. Con il lancio della Geforce GTX 280 Nvidia detiene lo scettro di scheda video più potente e veloce ad oggi in commercio a singola GPU, superando la rivale Amd con la sua soluzione a singola GPU ATI HD4870, anche se pur di poco, mediamente un 12%. La tecnologia GT200 ha permesso di scalare, nella maggior parte dei casi, il frame rate in modo efficiente, e lineare. I Forceware 177.41 WHQL si sono dimostrati driver maturi e stabili,che sfruttano a dovere tutta la potenzialità della scheda..

La nuova scheda Gainward GeForce GTX 280 è una scheda video esigete in termini di consumi. I valori ottenuti mettendo sotto stress la scheda parlano di 490 watt in riferimento al sistema completo, valore che costringe l’utente finale ad adottare un alimentatore adeguato, qualora non ne avesse già uno. Troviamo nella soluzione Gainward un sistema di raffreddamento efficiente, ma rumoroso se non regolato a dovere tramite programmi di monitoraggio come “RivaTuner “.

Abbastanza buono è il prezzo di vendita, che attualmente è di 375,00€ IVA inclusa, cifra abbastanza elevata, ma abbastanza appropriata, visto le performance della scheda e l’alto costo di produzione. Ricordiamo che il die della GT200 misura 650 millimetri quadrati ed è a 65 nm. Questo si ripercuote sul costo elevato che Nvidia ha nella produzione del suo GT200.

La qualità costruttiva della Gainward GeForce GTX 280 è veramente eccellente ed impareggiabile, tutti i componenti sono di altissima qualità, tanto da godere della garanzia di 3 anni da parte dello stesso produttore.

Le funzionalità aggiuntive incluse nella GTX 280, non fanno altro che aumentarne il valore. L'integrazione della tecnologia Hybrid SLI, permette in abbinamento ad una scheda madre NVIDIA di ultima generazione, di risparmiare sulla bolletta energetica in tutte quelle condizioni in cui la scheda video non è un collo di bottiglia, la presenza dell'ultima revisione del Pure Video HD, permette una fluida riproduzione dei contenuti in SD e HD senza incidere sulle performance complessive del sistema.

La nuova possibilità di effettuare il Triple SLI ci permette di poter creare piattaforme da gioco sempre più potenti e complete, anche grazie alla possibilità di poter sfruttare una nuova tecnologia come l’nVidia PhysX, che permette”quando sarà sfruttata a dovere” di rendere i giochi decisamente più realistici e veloci.

Molto interessante è l’introduzione della nuova tecnologia CUDA., che promette di snellire, attraverso soluzioni ben ottimizzate per la scheda, il carico di lavoro della cpu grazie all’uso più massiccio gpu.

Sebbene la nuova Geforce GTX 280 risulti essere la GPU più performante in commercio, non significa che sia un prodotto perfetto. Peccato che Nvidia non abbia puntato su un processo produttivo inferiore ai 65 nm, questo avrebbe senza dubbio diminuito di costi di produzione del GT200 a tutto vantaggio del consumatore finale, che avrebbe potuto beneficiare di un prezzo di vendita decisamente più competitivo.

Nvidia anche con queste nuove schede video non ha adottato il supporto alle nuove librerie Microsoft DirectX 10.1 e agli Shader Model 4.1, e sinceramente la cosa ci lascia stupiti.

Il PhysX di Nvidia, ancora ad oggi è veramente molto poco sfruttato con i giochi, sicuramente lo sarà molto di più in un futuro prossimo.

In Conclusione la Gainward GeForce GTX 280 è in grado di far girare senza alcun problema anche utilizzando risoluzioni elevate e filtri, la totalità dei giochi presenti attualmente nel mercato. Giochi più esigenti come “Crysis” vengono digeriti in maniera buona anche in DX10 ma senza filtri attivi.

Ancora una volta Nvidia ha deciso di seguire la sua politica, ovvero spingere la sua proposta di “punta” su un unico immenso die. Non sarebbe stato meglio fare una dual GPU, come invece ha fatto AMD con la sua top HD4870X2?....vedremo presto chi tra Nvidia e AMD sarà la regina delle prestazioni.

Consigliamo la GTX 280 a tutte quelle persone che pretendono il massimo da tutti i giochi in ogni situazione e che per ottenerlo sono disposti a tutto.

Pro:

- Prestazioni al Top, anche con risoluzioni alte e filtri attivi.

- Ottime prestazioni in Overclok.

- Ottima qualità costruttiva.

- Ottime le tecnologia Hybrid SLI, Pure Video HD,CUDA , nVidia PhysX. e Triple SLI.

Contro:

- Prezzo di vendita abbastanza elevato.

- Consumi abbastanza elevati.

- Temperature di esercizio in idle elevate.

- Mancanza del supporto alle nuove librerie Microsoft DirectX 10.1 e agli Shader Model 4.1.

Si ringrazia Gainward per averci fornito la scheda oggetto della nostra prova.

Antonio Delli Santi